Actualidad informática

Noticias y novedades sobre informática

La Curveball de 56 cubits de IBM puede afectar a los planes de computación cuántica de Google

Justo cuando parecía subestimada, la computación clásica está volviendo a atacar. IBM ha ideado una manera de simular ordenadores cuánticos que tienen 56 bits cuánticos, o cubits, en un superordenador no cuántico – una tarea que antes se creía imposible. La hazaña mueve los palos de la portería en la lucha por la supremacía cuántica, el esfuerzo por superar a las computadoras clásicas usando las cuánticas.

Justo cuando parecía subestimada, la computación clásica está volviendo a atacar. IBM ha ideado una manera de simular ordenadores cuánticos que tienen 56 bits cuánticos, o cubits, en un superordenador no cuántico – una tarea que antes se creía imposible. La hazaña mueve los palos de la portería en la lucha por la supremacía cuántica, el esfuerzo por superar a las computadoras clásicas usando las cuánticas.

Antes se aceptaba ampliamente que un ordenador clásico no puede simular más de 49 qubits debido a limitaciones de memoria. La memoria necesaria para las simulaciones aumenta exponencialmente con cada cubit adicional.

Lo más cerca que se había llegado a poner a prueba el límite de 49 bits era una simulación de 45 bits en el Instituto Federal Suizo de Tecnología de Zúrich, que necesitaba 500 terabytes de memoria. La nueva simulación de IBM eleva la suposición al simular 56 qubits con sólo 4,5 terabytes.

La simulación se basa en un truco matemático que permite una representación numérica más compacta de los diferentes arreglos de qubits, conocidos como estados cuánticos.

Una operación de computación cuántica es típicamente representada por una tabla de números que indica lo que se debe hacer a cada cubit para producir un nuevo estado cuántico. En su lugar, los investigadores del Centro de Investigación T. J. Watson de IBM en Yorktown Heights, Nueva York, utilizaron tensores – tablas efectivamente multidimensionales aumentadas con ejes más allá de filas y columnas.

Gracias a los ejes adicionales, se puede introducir mucha más información en unos cuantos tensores, siempre y cuando sepamos escribirla en el lenguaje de los tensores. Los investigadores encontraron una forma de hacer precisamente eso para las operaciones de computación cuántica.

Vergonzosamente paralelos

Al escribir las operaciones en forma tensorial, también descubrieron una manera de dividir la tarea de simulación en lo que ellos llaman trozos «vergonzosamente paralelos», lo que les permitió usar los muchos procesadores de un supercomputador simultáneamente. Esto les ganó el último bit de eficiencia necesario para simular una computadora cuántica de 56 bits.

IBM se ha pasado de la raya «, dice Itay Hen de la Universidad del Sur de California. «Será mucho más difícil para la gente de dispositivos cuánticos exhibir supremacía.»

IBM tiene ahora un ordenador cuántico funcional de 56 bits que vive en su supercomputadora. Pero mientras que eso es una mejora con respecto al récord anterior, Andrew Childs en la Universidad de Maryland dice que no es un gran salto hacia adelante. No creo que estén afirmando que esto vaya a darles una simulación eficiente de sistemas cuánticos en un ordenador clásico «, dice.

Aun así, han subido la apuesta en la carrera por superar a los ordenadores clásicos con sistemas cuánticos. Google dijo anteriormente que estaban en camino de construir un procesador de 49 bits a finales de 2017, pero eso ya no les permitirá alcanzar la supremacía cuántica.

De hecho, Bob Wisnieff, el investigador principal del estudio de IBM, dice que su simulación actual funciona cerca de «mil millones de veces más lento» que las estimaciones teóricas para una computadora cuántica real de 56 cubits.

El equipo de Wisnieff planea experimentar con supercomputadoras cuyos procesadores pueden comunicarse eficazmente entre sí. Esperan poder exprimir unos cuantos más de estos canales de comunicación, lo que ayuda a acelerar el cálculo paralelo necesario para la simulación.

El objetivo de IBM es construir una computadora cuántica que pueda «explorar problemas prácticos» como la química cuántica, dice Wisnieff. Espera comprobar la precisión de las computadoras cuánticas frente a sus simulaciones antes de poner a prueba las computadoras cuánticas reales.

«Quiero ser capaz de escribir algoritmos para los que conozco las respuestas antes de ejecutarlos en una computadora cuántica real «, dice.

Referencia: arxiv.org/abs/1710.05867

La guía del fabricante de medicamentos para la galaxia

En 2016, la empresa farmacéutica Sunovion asignó a un grupo de profesionales experimentados una misión inusual. En la sede central de la firma en Marlborough, Massachusetts, a todos los químicos se les pidió que participaran en un juego para ver quién podía descubrir las mejores pistas de medicamentos nuevos. En sus puestos de trabajo había una cuadrícula de cientos de estructuras químicas, de las cuales sólo diez estaban etiquetadas con información sobre sus efectos biológicos. Los expertos tuvieron que seleccionar otras moléculas que podrían resultar ser candidatas a medicamentos, utilizando sus conocimientos de estructura química y biología, que tanto les costó aprender. De los 11 jugadores, 10 lucharon durante varias horas. Pero uno de ellos consiguió pasar en milisegundos, porque era un algoritmo.

Ese programa de computación fue la creación de Willem van Hoorn, jefe de quimioinformática de Exscientia, una empresa que usa inteligencia artificial (IA) para diseñar medicamentos. La firma, con sede en Dundee, Reino Unido, quería ampliar una incipiente asociación con Sunovion, por lo que las apuestas eran altas. «Mi credibilidad estaba en juego», dice van Hoorn. Veinte rondas de juego más tarde, él anotó los puntos. El alivio lo invadió. Su algoritmo había dominado al menos algunas de las artes oscuras de la química; sólo un experto en caza de drogas había derrotado a la máquina.

Desde entonces, Exscientia y Sunovion han seguido trabajando juntas para descubrir fármacos psiquiátricos. «Esta competencia realmente ayudó a que la gente que toma las decisiones de investigación química se comprometiera», dice Scott Brown, director de química computacional de Sunovion.

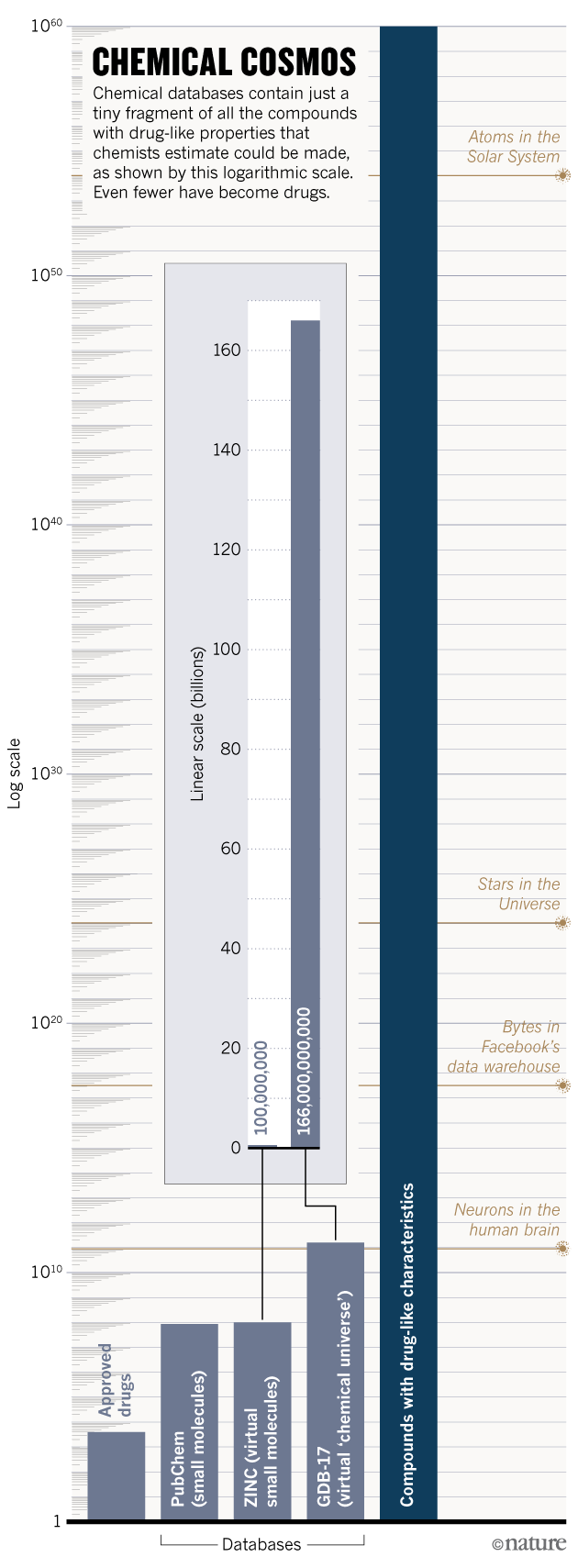

Exscientia es sólo uno de los numerosos grupos de la industria y el mundo académico que están recurriendo a las computadoras para explorar el asombroso y gran universo químico. Los químicos estiman que se podrían hacer 10^60 compuestos con características parecidas a las de un fármaco, es decir, moléculas más pequeñas que átomos hay en el Sistema Solar. La esperanza es que los algoritmos catalogarán, caracterizarán y compararán las propiedades de millones de compuestos para ayudar a los investigadores a encontrar rápidamente y de manera asequible los mejores candidatos para un objetivo. Los defensores argumentan que estas estrategias podrían hacer que los medicamentos sean más seguros, asegurar que menos medicamentos fallen en los ensayos clínicos y permitir el descubrimiento de nuevas clases de terapias. También podrían ayudar a abrir áreas de espacio químico que quedan inexploradas o supuestamente estériles.

Pero muchos químicos medicinales se muestran escépticos ante la exageración, no convencidos de que la inefable complejidad de la química pueda reducirse a simples líneas de código. Incluso los defensores de la IA reconocen que muchos intentos han fracasado: los compuestos generados por computadora pueden estar plagados de componentes difíciles de fabricar, como los anillos de 3 o 4 átomos, e infestados con grupos reactivos que activan las alarmas de seguridad. «La ejecución de algunos enfoques computacionales puede sufrir mucho cuando los investigadores simplemente no conocen el campo», dice van Hoorn. «Los compuestos que se les ocurren son simplemente ridículos», pero afirma que un toque humano experto podría domar a estos diseñadores digitales demasiado entusiastas. «Creo que algunas de estas ideas podrían funcionar si los informáticos colaboraran con gente que realmente respira química.»

Exploración espacial

Para navegar por el universo químico, ayuda tener un mapa. En 2001, el químico Jean-Louis Reymond, de la Universidad de Berna (Suiza), comenzó a utilizar ordenadores para trazar la mayor parte del espacio masivo posible. Dieciséis años después, ha acumulado la mayor base de datos de moléculas pequeñas del mundo, una gigantesca colección virtual de 166 mil millones de compuestos. La base de datos, llamada GDB-17, incluye todas las moléculas orgánicas químicamente factibles, compuestas de hasta 17 átomos, tantas como los ordenadores de Reymond puedan soportar. Sólo para que un ordenador pueda compilar una lista de los compuestos de la base de datos llevaría ahora más de 10 horas», dice Reymond.

Para dar sentido a esta plétora de posibles puntos de partida de medicamentos, Reymond ha ideado una forma de organizar su universo químico. Inspirándose en la tabla periódica, ha agrupado los compuestos en un espacio multidimensional en el que los compuestos vecinos tienen propiedades relacionadas. Las posiciones se asignan de acuerdo a 42 características, tales como cuántos átomos de carbono tiene cada compuesto.

Por cada medicamento que ha llegado al mercado, hay millones de compuestos que son químicamente casi idénticos a él – solo que tienen un hidrógeno extra aquí o doble enlace allí. Y algunos de estos funcionarán mejor que el medicamento aprobado. Los químicos no podrían concebir todas estas variaciones sin ayuda. «No hay manera de llegar a estos isómeros usando un bolígrafo y un pedazo de papel», dice Reymond.

Pero Reymond y su equipo pueden identificar «vecinos cercanos» terapéuticamente prometedores de drogas probadas mediante la búsqueda de similitudes entre los compuestos. Al utilizar un medicamento en particular como punto de partida, el equipo puede peinar los 166 mil millones de compuestos en la base de datos para obtener candidatos de seguimiento convincentes en sólo 3 minutos. En un experimento de prueba de principio, Reymond comenzó con una molécula conocida que une el receptor de acetilcolina nicotínica, un objetivo útil para trastornos que involucran el sistema nervioso o la función muscular, y compiló una lista corta de 344 compuestos relacionados. El equipo sintetizó tres, y descubrió que dos podrían activar el receptor de forma potente, y podrían ser útiles para tratar la atrofia muscular en el envejecimiento. El enfoque es como usar un mapa geológico para determinar dónde buscar oro, dice Reymond. «Necesitas alguna forma de elegir dónde vas a cavar», dice.

Un enfoque alternativo utiliza las computadoras para buscar oro en muchos lugares sin preocuparse demasiado por la ubicación inicial. En términos de búsqueda de medicamentos, esto significa que se deben buscar en sílice grandes bibliotecas químicas para encontrar pequeñas moléculas que se unen a una proteína dada. Primero, los investigadores tienen que tomar una instantánea de una proteína usando cristalografía de rayos X para determinar la forma de su sitio de unión. Luego, usando algoritmos de acoplamiento molecular, los químicos computacionales pueden escarbar a través de colecciones de compuestos para encontrar los mejores ajustes para cualquier sitio dado.

A medida que la potencia de computación ha explotado, las capacidades de estos algoritmos han mejorado. Los químicos de la Universidad de California en San Francisco, encabezados por Brian Shoichet, mostraron el potencial de este enfoque en 2016 en la búsqueda de una nueva clase de analgésicos. El equipo revisó más de tres millones de compuestos comercialmente disponibles para encontrar candidatos que activaran selectivamente la señalización del receptor de opiáceos para aliviar el dolor sin alterar la vía de señalización de detención de opiáceos estrechamente relacionada, que se cree que está asociada con los efectos secundarios de los opiáceos, incluyendo una menor frecuencia respiratoria y estreñimiento. Los investigadores rápidamente redujeron una biblioteca masiva de compuestos a sólo 23 compuestos altamente clasificados para el seguimiento.

En el tubo de ensayo, siete de los candidatos tuvieron la actividad deseada. El desarrollo posterior convirtió a uno de estos en PZM21, un compuesto que actúa sobre el receptor de los opiáceos sin activar la beta-arrestina. La firma biotecnológica Epiodyne, con sede en San Francisco, California, y cofundada por Shoichet, está ahora tratando de desarrollar un analgésico más seguro basado en los hallazgos. Shoichet planea utilizar el mismo enfoque para encontrar compuestos que modulen otros receptores acoplados a la proteína G (GPCR), una familia de proteínas que representa aproximadamente el 40% de los objetivos de medicamentos.

Su equipo también está llevando a cabo experimentos similares con una nebulosa virtual de 100 millones de compuestos que nunca se han hecho antes, pero que debería ser fácil de sintetizar. Los desarrolladores de medicamentos industriales también están probando este enfoque: la firma biotecnológica Nimbus Therapeutics, con sede en Cambridge, Massachusetts, incorpora en sus pantallas de acoplamiento compuestos virtuales con características de sustancias químicas naturales que normalmente tienen que ser obtenidas laboriosamente de entornos naturales como el suelo. El jurado todavía no está claro si esto conducirá a los medicamentos, pero Don Nicholson, director ejecutivo de la compañía, dice que para al menos un programa de diseño de fármacos, «de aquí vienen todos nuestros éxitos».

Los resultados preliminares de este tipo de pruebas virtuales están sacudiendo uno de los supuestos básicos de Shoichet sobre el espacio químico: que sólo vale la pena mirar en regiones establecidas y ricas en medicamentos. Galaxias bien caracterizadas de moléculas están tan inundadas con compuestos biológicamente activos que algunos argumentan que es una pérdida de tiempo buscar en otro lugar. «A lo largo de mi carrera he creído esa línea de razonamiento. Tenía sentido, aunque no hubiera tanta evidencia que lo apoyara «, dice Shoichet. Pero los resultados inéditos de sus cribas de 100 millones de compuestos están avivando su interés en las regiones menos exploradas del espacio químico. «Empiezo a pensar que esas galaxias están llenas de oro.»

… …

Ampliar en: nature

Físicos encuentran que no estamos viviendo en una simulación por ordenador

Por si acaso has estado pensando en ello, ahora puedes relajarte. Un equipo de físicos teóricos de la Universidad de Oxford en el Reino Unido ha demostrado que la vida y la realidad no pueden ser meras simulaciones generadas por un ordenador extraterrestre masivo.

El hallazgo, inesperadamente definido, surgió del descubrimiento de un vínculo novedoso entre las anomalías gravitacionales y la complejidad computacional.

En un artículo publicado en la revista Science Advances, Zohar Ringel y Dmitry Kovrizhi demuestran que la construcción de una simulación computarizada de un fenómeno cuántico particular que ocurre en los metales es imposible – no sólo prácticamente, sino en principio.

Inicialmente, la pareja se propuso ver si era posible utilizar una técnica conocida como Monte Carlo cuántico para estudiar el efecto Hall cuántico, un fenómeno en los sistemas físicos que exhiben fuertes campos magnéticos y temperaturas muy bajas, y se manifiesta como una corriente de energía que atraviesa el gradiente de temperatura. El fenómeno indica una anomalía en la geometría espacial-tiempo subyacente.

Los métodos de Monte Carlo cuántico utilizan el muestreo aleatorio para analizar los problemas cuánticos de muchos cuerpos donde las ecuaciones involucradas no pueden ser resueltas directamente.

Ringel y Kovrizhi mostraron que los intentos de usar Monte Carlo cuántico para modelar sistemas que exhiben anomalías, como el efecto Hall cuántico, siempre serán inviables. Descubrieron que la complejidad de la simulación aumentaba exponencialmente con el número de partículas que se estaban simulando.

Si la complejidad creciera linealmente con el número de partículas que se están simulando, duplicar el número de partículas significaría duplicar la potencia de computación requerida. Sin embargo, si la complejidad crece en una escala exponencial -donde la cantidad de potencia de computación tiene que duplicarse cada vez que se agrega una sola partícula- entonces la tarea se vuelve rápidamente imposible.

Los investigadores calcularon que almacenar información sobre un par de cientos de electrones requeriría una memoria de computadora que físicamente requeriría más átomos de los que existen en el universo.

Los investigadores notan que hay un número de otras interacciones cuánticas conocidas para las que aún no se han encontrado algoritmos predictivos. Sugieren que para algunos de ellos, de hecho, puede que nunca se encuentren.

Y dado que la cantidad físicamente imposible de tareas informáticas necesarias para almacenar información para un solo miembro de este subconjunto, los temores de que podríamos estar viviendo inconscientemente en una vasta versión de La Matriz ahora se puede eliminar.

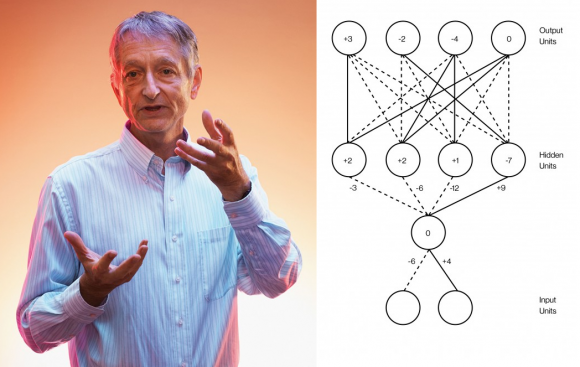

Geoffrey Hinton, el padre del aprendizaje profundo (deep learning)

La Inteligencia Artificial está de moda gracias al aprendizaje profundo (deep learning), las redes de neuronas artificiales multicapa entrenadas con un algoritmo de retropropagación (backprop). Mucha gente cree ver una revolución emergente en esta tecnología; sin embargo, casi nada ha cambiado desde que el padre del aprendizaje profundo, Geoffrey Hinton, junto a dos colegas, introdujera el algoritmo de retropropagación en 1986. No solo lo digo yo en mis charlas, también lo dice él mismo, quien ahora es el científico más citado en aprendizaje profundo con gran diferencia respecto al siguiente.

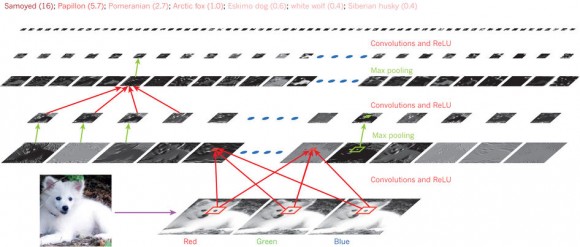

En 2012, Hinton y dos estudiantes demostraron que las redes de neuronas artificiales convolucionales podían reconocer imágenes con mayor precisión que cualquier otra técnica basada en inteligencia artificial. El secreto de estas redes era su número de neuronas por capa (la red tenía nueve capas): la primera capa tenía 150 528 neuronas (para recibir como entrada una imagen en color de 224 × 224 × 3 píxeles); tras aplicar 96 filtros de 11 × 11 × 3 se pasaba a la segunda capa con 253 440 neuronas; tras aplicar 256 filtros de 5 × 5 × 48 se pasaba a la tercera capa de 86 624 neuronas; tras 384 filtros de 3 × 3 × 256 se pasaba a la cuarta capa de 64 896 neuronas; tras aplicar 384 filtros de 3 × 3 × 192 se pasaba a la quinta capa de 64 896 neuronas; tras otros 256 filtros de 3 × 3 × 192 se pasaba a la sexta capa de 43 264 neuronas; finalmente, sin filtros, se encuentran tres capas de 4096, 4096, y 1000 neuronas. Esta última capa clasifica las imágenes de entrada en hasta 1000 clases diferentes.

Puede parecer que cambiar cientos o miles de neuronas por millones de neuronas es un cambio pequeño. Sin embargo, la potencia lograda con el cambio sorprendió a muchos, lo que llevó a Hinton a volver a publicar en Nature (no lo hacía desde 1986) y a que muchas empresas (Google, Apple, Facebook, etc.) se apuntasen al carro del aprendizaje profundo. Sin embargo, los grandes problemas de las redes de neuronas artificiales entrenadas con retropropagación no han sido resueltos aún. Entre ellos el problema del cuello de botella de la información (information bottleneck), descubierto en 1999.

El propio Hinton dice que “la mayoría de las conferencias sobre aprendizaje profundo solo presentan pequeñas variaciones de los algoritmos, sin plantearse problemas profundos sobre estos algoritmos”. En la inteligencia artificial hay más ingeniería que ciencia básica. Los avances futuros requieren una comprensión básica de cómo funcionan los sistemas de aprendizaje profundo y qué relación tienen con el funcionamiento de la mente humana.

Ampliar en: NAUKAS

Intel presenta un chip superconductor de 17 qubits

Intel anunció la entrega de un chip de prueba superconductor de 17 qubits para computación cuántica a QuTech, el socio de investigación cuántica de Intel en los Países Bajos. El nuevo chip fue fabricado por Intel y cuenta con un diseño único para mejorar el rendimiento y las prestaciones.

La entrega de este chip demuestra el rápido progreso que Intel y QuTech están haciendo en la investigación y el desarrollo de un sistema de computación cuántica en funcionamiento. También subraya la importancia de la ciencia de los materiales y la fabricación de semiconductores para hacer realidad la promesa de la informática cuántica.

La computación cuántica, en esencia, es lo último en computación paralela, con el potencial de abordar problemas que los ordenadores convencionales no pueden manejar. Por ejemplo, los ordenadores cuánticos pueden simular la naturaleza para avanzar en investigación química, ciencia de los materiales y modelado molecular, como ayudar a crear un nuevo catalizador para capturar dióxido de carbono, un superconductor a temperatura ambiente o descubrir nuevos fármacos.

Sin embargo, a pesar de los grandes avances experimentales y la especulación, existen desafíos inherentes a la construcción de sistemas cuánticos viables y a gran escala que produzcan resultados precisos. Uno de esos obstáculos es la uniformidad y estabilidad de los qubits (los bloques básicos de la computación cuántica).

Los Qubits son tremendamente frágiles, y cualquier ruido u observación involuntaria de ellos puede causar pérdida de datos. Esta fragilidad requiere que operen a una temperatura de alrededor de 20 millikelvin, 250 veces más fría que el espacio profundo, y este entorno operativo extremo hace que el empaquetado de qubits sea clave para su rendimiento y función. El Grupo de Investigación de Componentes (CR) de Intel en Oregon y los equipos de Pruebas de Ensamblaje y Desarrollo de Tecnología (ATTD) en Arizona están sobrepasando los límites del diseño de chips y la tecnología de empaque para abordar los desafíos únicos de la computación cuántica.

Aproximadamente del tamaño de un cuarto (en un envase del tamaño de una moneda de medio dólar), las características de diseño mejoradas del nuevo chip de prueba de 17 bits incluyen:

– Nueva arquitectura que permite mejorar la fiabilidad, el rendimiento térmico y reducir la interferencia de radiofrecuencia (RF) entre los qubits.

– Esquema de interconexión escalable que permite 10-100 veces más señales de entrada y salida del chip en comparación con los chips conectados por cable.

– Procesos, materiales y diseños avanzados que permiten a los dispositivos de empaquetado de Intel escalar para circuitos cuánticos integrados, que son mucho más grandes que los chips de silicio convencionales.

«Nuestra investigación cuántica ha progresado hasta el punto de que nuestro socio QuTech está simulando cargas de trabajo de algoritmos cuánticos, e Intel está fabricando nuevos chips de prueba de qubit con regularidad en nuestras modernas instalaciones de fabricación», afirmó el Dr. Michael Mayberry, vicepresidente corporativo y director general de Intel Labs. «La experiencia de Intel en fabricación, electrónica de control y arquitectura nos distingue y nos servirá de la mejor manera a medida que nos adentramos en nuevos paradigmas de computación, desde la informática neuromórfica a la cuántica».

La relación de colaboración de Intel con QuTech para acelerar los avances en computación cuántica comenzó en 2015. Desde entonces, la colaboración ha logrado muchos hitos: desde demostrar los bloques de circuitos clave para un sistema de control criogénico-CMOS integrado, hasta desarrollar un flujo de fabricación de qubit spin en la tecnología de proceso de 300 mm de Intel, y desarrollar esta solución de empaque única para los qubits superconductores. A través de esta asociación, el tiempo desde el diseño y la fabricación hasta la prueba se ha acelerado enormemente.

Con este chip de prueba, nos centraremos en conectar, controlar y medir múltiples y entrelazadas salidas hacia un esquema de corrección de errores y un qubit lógico «, del profesor Leo DiCarlo de QuTech. «Este trabajo nos permitirá descubrir nuevos conocimientos en computación cuántica que darán forma a la próxima etapa de desarrollo».

Avance del sistema de computación cuántica

El trabajo de Intel y QuTech en computación cuántica va mucho más allá del desarrollo y prueba de dispositivos de qubit superconductores. La colaboración abarca todo el sistema cuántico -o «pila» – desde los dispositivos de qubit hasta la arquitectura de hardware y software necesaria para controlar estos dispositivos, así como las aplicaciones cuánticas. Todos estos elementos son esenciales para que la computación cuántica avance de la investigación a la realidad.

Además, a diferencia de otros, Intel está investigando varios tipos de qubit. Estos incluyen los qubits superconductores incorporados en este nuevo chip de prueba, y un tipo alternativo llamado spin qubits en silicio. Estos espín qubits se asemejan a un transistor de un solo electrón similar en muchos aspectos a los transistores convencionales y potencialmente capaz de ser fabricado con procesos comparables.

Mientras que las computadoras cuánticas prometen mayor eficiencia y rendimiento para manejar ciertos problemas, no reemplazarán la necesidad de computación convencional u otras tecnologías emergentes como la computación neuromórfica. Y necesitaremos los avances técnicos que la ley de Moore ofrece para inventar y ampliar estas tecnologías emergentes.

Intel está invirtiendo no sólo para inventar nuevas formas de computación, sino también para avanzar en la fundamentación de la Ley de Moore, que hace posible este futuro.

Ampliar en: nextBIG FUTURE

Fraunhofer investigará la electrónica biodegradable para implantes activos

Un año después de iniciar este proyecto, los socios investigadores Fraunhofer Institute for Electronic Nano Systems ENAS, el Fraunhofer Institute for Biomedical Engineering IBMT, el Fraunhofer Institute for Silicate Research ISC, y el Fraunhofer Resource Recycling and Strategy Project Group IWKS y Fraunhofer FEP presentarán sus primeros resultados durante el Semicon Europe 2017 como parte de productronica 2017 en Munich.

Un año después de iniciar este proyecto, los socios investigadores Fraunhofer Institute for Electronic Nano Systems ENAS, el Fraunhofer Institute for Biomedical Engineering IBMT, el Fraunhofer Institute for Silicate Research ISC, y el Fraunhofer Resource Recycling and Strategy Project Group IWKS y Fraunhofer FEP presentarán sus primeros resultados durante el Semicon Europe 2017 como parte de productronica 2017 en Munich.

Los componentes electrónicos que se pueden descomponer por completo en un entorno biológico después de una vida útil predefinida abren nuevas posibilidades de aplicación, así como formas de reducir su huella ecológica. Para ello, Fraunhofer FEP ha desarrollado tecnologías de vacío para la fabricación de materiales conductores biodegradables en sustratos biodegradables. Los implantes médicos activos construidos con componentes biodegradables podrían ser reabsorbidos por el tejido, ahorrando al paciente una segunda intervención quirúrgica para la extracción del implante después de su vida útil.

La Fraunhofer Gesellschaft e. V. está financiando el proyecto «BioElektron – Biodegradable Electronics for Active Implants» a través de su programa interno (financiamiento No. MAVO B31 301).

Este proyecto se centrará en el desarrollo de componentes esenciales para las piezas electrónicas biodegradables que se emplearán, por ejemplo, en un implante. Entre ellas se incluyen las estructuras conductoras biodegradables, los electrodos biodegradables para recoger señales eléctricas o suministrar estimulación eléctrica (por ejemplo, para la monitorización cerebral), los transistores y circuitos biodegradables de película delgada y todas sus capas asociadas de aislamiento eléctrico y de protección contra la humedad y los gases. Todos estos elementos deben integrarse monolíticamente en un dispositivo flexible de película delgada.

El magnesio es conocido por ser un metal biodegradable y biológicamente compatible y ya se emplea en entornos clínicos como material de implante absorbible. Basándose en los procesos de evaporación y deposición térmica al vacío, Fraunhofer FEP desarrolla estructuras conductoras y transistores orgánicos de capa fina a base de magnesio. El reto consiste en depositar este metal sobre láminas poliméricas biodegradables que el magnesio no se adhiere lo suficiente al control normal del proceso. Mediante un pretratamiento adecuado de los sustratos mediante una combinación de secado, tratamiento con plasma y capas de semillas se pueden producir estructuras conductoras de alta calidad y finamente estructuradas.

«Ahora estamos preparados para discutir estos resultados con socios interesados de la industria y la comunidad científica durante la productronica 2017 en el stand conjunto Silicon-Sajonia (pabellón B1, stand B1-416) con el fin de poder aplicarlos en las aplicaciones prácticas actuales», explica el Dr. Michael Hoffmann de Fraunhofer FEP y director del proyecto bioElektron.

Fuente: www.fep.fraunhofer.de/en/ueber-uns/projekte/bioElektron.html

Ampliar en:

Viendo la próxima dimensión de los chips de ordenador

Una colaboración de investigación entre la Universidad de Osaka y el Instituto de Ciencia y Tecnología de Nara utilizó por primera vez la microscopía de barrido en túnel (STM) para crear imágenes de superficies laterales atómicamente planas de cristales de silicio 3D. Este trabajo ayuda a los fabricantes de semiconductores a seguir innovando y, al mismo tiempo, produce chips de ordenador más pequeños, rápidos y eficientes energéticamente para ordenadores y teléfonos inteligentes.

Una colaboración de investigación entre la Universidad de Osaka y el Instituto de Ciencia y Tecnología de Nara utilizó por primera vez la microscopía de barrido en túnel (STM) para crear imágenes de superficies laterales atómicamente planas de cristales de silicio 3D. Este trabajo ayuda a los fabricantes de semiconductores a seguir innovando y, al mismo tiempo, produce chips de ordenador más pequeños, rápidos y eficientes energéticamente para ordenadores y teléfonos inteligentes.

Nuestros ordenadores y teléfonos inteligentes están cargados con millones de pequeños transistores. La velocidad de procesamiento de estos dispositivos ha aumentado dramáticamente con el paso del tiempo a medida que aumenta el número de transistores que pueden caber en un solo chip de ordenador. Basado en la Ley de Moore, el número de transistores por chip se duplicará cada dos años, y en esta área parece que se mantiene. Para mantener este ritmo de rápida innovación, los fabricantes de ordenadores están continuamente en busca de nuevos métodos para hacer que cada transistor sea cada vez más pequeño.

Los microprocesadores actuales se fabrican añadiendo patrones de circuitos a las obleas de silicio plano. Una forma novedosa de crear más transistores en el mismo espacio es fabricar estructuras 3D. Los transistores de efecto de campo de tipo aleta (FET) se denominan así porque tienen estructuras de silicio parecidas a las aletas que se extienden hacia el aire, fuera de la superficie del chip. Sin embargo, este nuevo método requiere un cristal de silicio con superficies superiores y laterales perfectamente planas, en lugar de sólo la superficie superior, como ocurre con los dispositivos actuales. El diseño de la próxima generación de chips requerirá nuevos conocimientos sobre las estructuras atómicas de las superficies laterales.

Ahora, investigadores de la Universidad de Osaka y del Instituto de Ciencia y Tecnología de Nara informan que han utilizado STM para visualizar por primera vez la superficie lateral de un cristal de silicio. STM es una técnica poderosa que permite ver la ubicación de los átomos de silicio individuales. Al pasar una punta afilada muy cerca de la muestra, los electrones pueden saltar a través de la separación y crear una corriente eléctrica. El microscopio monitoreó esta corriente y determinó la ubicación de los átomos en la muestra.

«Nuestro estudio es un gran primer paso hacia la evaluación de transistores con resolución atómica diseñada para obtener formas tridimensionales», dice la coautora del estudio Azusa Hattori.

Para hacer que las superficies laterales sean lo más suaves posible, los investigadores primero trataron los cristales con un proceso llamado ataque de iones reactivos. El coautor Hidekazu Tanaka dice: «Nuestra habilidad de mirar directamente las superficies laterales usando STM demuestra que podemos hacer estructuras artificiales en 3D con superficies atómicas casi perfectas».

Ampliar en: Solid State TECHNOLOGY

Adopción masiva de tecnologías láser para la fabricación de semiconductores

Los fabricantes de semiconductores disponen hoy en día de una amplia variedad de tecnologías láser que permiten el desarrollo de procesos innovadores de fabricación de semiconductores. Según Yole Développement (Yole), el mercado de los equipos láser crecerá a una tasa de crecimiento del 15% CAGR entre 2016 y 2022 y debería alcanzar más de 4000 millones de dólares para 2022 (excluyendo el marcado). Estas cifras muestran la adopción masiva de tecnologías láser para los procesos de fabricación de semiconductores.

En su último informe titulado Laser Technologies for Semiconductor Manufacturing, la compañía consultora de investigación de mercado y estrategia detalla el estado de esta industria, impulsada principalmente por el troquelado, a través de perforaciones y patrones en PCB flex y PCB HDI, sustratos de CI y procesamiento de dispositivos semiconductores.

El informe de Yole Laser Technologies for Semiconductor Manufacturing proporciona un análisis exhaustivo de los diferentes equipos láser existentes y soluciones de fuentes láser desarrolladas para los pasos del proceso de semiconductores. Se trata de un análisis exhaustivo que resalta el nivel de madurez de cada tipo de láser, basado en una hoja de ruta técnica hasta el año 2022. Con este nuevo informe, los analistas de Yole ofrecen un claro entendimiento de los beneficios de las tecnologías láser y el valor agregado para cada proceso de fabricación.

El informe Laser Technologies for Semiconductor Manufacturing es el primero de una amplia colección de informes que Yole publicará en los próximos meses. Además, su 1st Executive Forum on Laser Technologies, que se lleva a cabo en Shenzhen, China, acogiendo a más de 100 asistentes, la empresa de investigación de mercado y consultoría estratégica «More than Moore» Yole confirma la expansión de sus actividades hacia las soluciones basadas en láser. Tecnologías, hojas de ruta, métricas de mercado, cadena de suministro, panorama competitivo, cuotas de mercado y mucho más. Todos estos temas serán descritos y analizados a fondo en los informes de mercado y tecnología láser de Yole.

Hoy en día, las aplicaciones de láser en la industria de los semiconductores son amplias y diversificadas. Varias tecnologías láser han comenzado a integrarse en los principales procesos de semiconductores, incluyendo el corte por láser, perforación, soldadura/adhesión, despegues, marcado, estampado, marcado, medición, deposición, y control por placas madre. Se utilizan para procesar dispositivos semiconductores, placas de circuito impreso flexibles y HDI, así como en aplicaciones de embalaje IC.

Los controladores de los métodos láser difieren de un paso del proceso a otro. Sin embargo, existen controladores similares y comunes para la aplicabilidad de los láseres a las aplicaciones de procesamiento de semiconductores y PCB. Las tendencias clave que impulsan la aplicabilidad del láser y contribuyen a su crecimiento son:

- El deseo de reducir el tamaño del troquel y, por lo tanto, de miniaturizar aún más los dispositivos accionados por ordenadores, dispositivos electrónicos portátiles como teléfonos móviles, tabletas y lectores de libros electrónicos, dispositivos portátiles y electrónica de consumo.

- Demanda de mayor rendimiento y rendimiento.

- Mejor calidad de troquelado.

- La necesidad de inspeccionar vacíos y partículas a través de un material transparente como el vidrio, que requiere el uso de métodos láser.

- Recocido por láser para una gran flexibilidad.

Sin embargo, la elección del tipo de procesamiento láser más adecuado depende en gran medida del material a procesar, los parámetros de procesamiento y el paso del proceso de fabricación.

El tipo de láser se define por parámetros como la longitud de onda, la emisión de luz UV, verde o IR, por ejemplo, así como la duración del pulso, por ejemplo, nanosegundo, picosegundo o femtosegundo. Los usuarios deben considerar qué longitud de pulso y longitud de onda es la correcta para su etapa de proceso y aplicación en semiconductores.

Los láseres de Nanosegundos son el tipo de láser más comúnmente utilizado en la fabricación de semiconductores y en el procesamiento de PCB, con una cuota de mercado superior al 60%. Les siguen los láseres de picosegundos, CO2 y femtosegundos. En el caso del paso de troquelado, la elección del tipo láser también depende del material y del sustrato a trocear. Para materiales de baja constante dieléctrica (baja k) se utilizan láseres UV de nanosegundos y picosegundos para optimizar la absorción óptica. Los láseres de infrarrojos Picosegundo y femtosegundo se utilizan típicamente para cortar sustratos de vidrio y zafiro, pero no para sustratos de SiC aislantes.

En la perforación, el tipo de láser empleado depende del sustrato. Los láseres UV de Nanosegundo se emplean generalmente en PCB flexibles, mientras que los láseres de CO2 se aplican en gran medida para sustratos de PCB HDI e IC. Sin embargo, para los sustratos de CI, la elección entre láser de CO2 y láser de nanosegundo o picosegundo UV depende de los diámetros de vía. Por debajo de los diámetros de 20 microm, la industria tiende a utilizar láseres UV de picosegundo, que son mucho más caros que los láseres UV de nanosegundo, pero que ofrecen una calidad superior.

En términos generales, el CO2 es la solución láser más barata y rápida y se utiliza en lugar de los láseres de estado sólido de nanosegundos, picosegundos o femtosegundos para cortar en cuadraditos, taladrar, estampar, marcar para aplicaciones que requieren alta potencia y no se preocupan por el daño por calor o la anchura de corte. Sin embargo, el CO2 es limitado cuando se necesitan características pequeñas. Los láseres de Nanosegundos son actualmente la tecnología dominante, pero los láseres de picosegundos y femtosegundos podrían avanzar en el mercado de equipos de corte láser. Sin embargo, la implementación del láser femtosegundo es más compleja y costosa.

El informe láser de Yole proporcionará una visión general completa del equipamiento láser y las fuentes láser utilizadas para cada aplicación de los pasos del procesamiento de semiconductores, junto con un análisis detallado de las tendencias de la tecnología láser y una previsión del mercado. También ofrecerá un análisis detallado del mercado de equipos láser por volumen y valor, su crecimiento para el período 2016-2022, y su desglose por tipo de láser y aplicación de pasos de proceso.

Ampliar en: Solid State TECHNOLOGY

autobus las palmas aeropuerto cetona de frambuesa