Actualidad informática

Noticias y novedades sobre informática

La teoría matemática de la comunicación de Shannon aplicada al secuenciado de ADN

Nadie sabe qué tecnología de secuenciado es más rápida debido a que nunca ha habido una forma justa de comparar las tasas a las que se extrae información del ADN. Hasta ahora.

Uno de los grandes héroes desconocidos de la ciencia del siglo XX es Claude Shannon, ingeniero de los famosos Laboratorios Bell durante su auge en la mitad del siglo XX. La más perdurable contribución a la ciencia por parte de Shannon es su teoría de la información: la idea que apuntala toda la comunicación digital.

En un famoso artículo que data de finales de la década de 1940, Shannon fijó el problema fundamental de la comunicación: reproducir en un punto del espacio un mensaje que se había creado en otro punto. El mensaje se codificaba inicialmente de alguna manera, se transmitía, y luego se decodificaba.

Shannon demostró que un mensaje siempre puede reproducirse en otro punto del espacio con una precisión arbitraria siempre que el ruido esté por debajo de un nivel umbral. Pasó luego a calcular cuánta información podría enviarse de esta forma, una propiedad conocida como capacidad del canal de información.

Las ideas de Shannon se han aplicado ampliamente a todas las formas de transmisión de información con gran éxito. Una vía particularmente interesante ha sido la aplicación de la teoría de la información a la biología – la idea de que la propia vida es la transmisión de información de una generación a la siguiente.

Este tipo de pensamiento revolucionario está en proceso y aún en sus primeras etapas. Queda mucho por llegar.

Hoy revisamos un interesante corolario en el área de la transmisión de información biológica. Abolfazl Motahari y sus colegas de la Universidad de California en Berkeley, usan la aproximación de Shannon para examinar cómo de rápidamente puede extraerse la información del ADN usando el proceso del secuenciado de escopeta.

El problema aquí es determinar la secuencia de nucleótidos (A,G,C y T) en un genoma. Esto requiere tiempo debido a que los genomas tienden a ser largos – por ejemplo, el genoma humano consta de unos 3000 millones de nucleótidos o pares de bases. Secuenciar esta cantidad en serie llevaría una infinidad de tiempo.

La aproximación de escopeta implica cortar el genoma en trozos aleatorios, que constan de entre 100 y 1000 bases, y secuenciarlas en paralelo. La información se vuelve a pegar in silico mediante un algoritmo conocido como de re-ensamblado.

Por supuesto, no hay forma de saber cómo re-ensamblar la información procedente de una única ‘lectura’ del genoma. Por lo que en la aproximación de escopeta, este proceso se repite muchas veces. Dado que cada lectura divide el genoma de una forma distinta, los otros inevitablemente se solapan con segmentos de la ejecución anterior. Estas áreas de solapamiento hacen posible el re-ensamblado de todo el genoma, como un rompecabezas.

Esto tiene el aspecto del problema clásico de la teoría de la información y, efectivamente, distintas personas han pensado en ello de esta forma. Sin embargo, Motahari y compañía van un paso más allá cambiando su enunciado más o menos exactamente a un análogo de la famosa aproximación de Shannon.

Dicen que el problema del secuenciado del genoma es esencialmente la reproducción de un mensaje escrito en el ADN a un formato electrónico digital. Según esta forma de abordarlo, el mensaje original está en el ADN, se codifica para su transmisión mediante el proceso de lectura y luego se decodifica por el algoritmo de re-ensamblado para producir una versión electrónica.

Lo que demuestran es que hay una capacidad del canal que define una tasa máxima para el flujo de información durante el proceso de secuenciado. “Ofrece el número máximo de pares de bases de ADN que pueden resolverse en cada lectura, mediante cualquier algoritmo de ensamblaje, sin importar las limitaciones computacionales”, comentan.

Esto es un resultado significativo para cualquiera interesado en el secuenciado de genomas. Un tema importante es lo rápido que una tecnología concreta de secuenciado puede realizar esta tarea, y si es más rápida o lenta que otras aproximaciones.

Por el momento no es posible calcularlo debido a que muchos de los algoritmos usados para ensamblado están diseñados para tecnologías y aproximaciones específicas a la lectura. Motohari y sus colegas dicen que hay, al menos, 20 algoritmos distintos de re-ensamblado, por ejemplo. “Esto hace difícil comparar distintos algoritmos”, comentan.

Por consiguiente, nadie sabe realmente cuál es más rápido, o incluso cuál tiene el potencial de ser más rápido.

El nuevo trabajo cambia esto. Por primera vez debería ser posible calcular lo cerca que está una tecnología concreta de secuenciado del límite teórico.

Esto podría forzar una limpieza de la madera muerta en esta área y estimular un periodo de innovación rápida en la tecnología del secuenciado.

Artículo de Referencia: arxiv.org/abs/1203.6233: Information Theory of DNA Sequencing

Traducido en: Ciencia Kanija

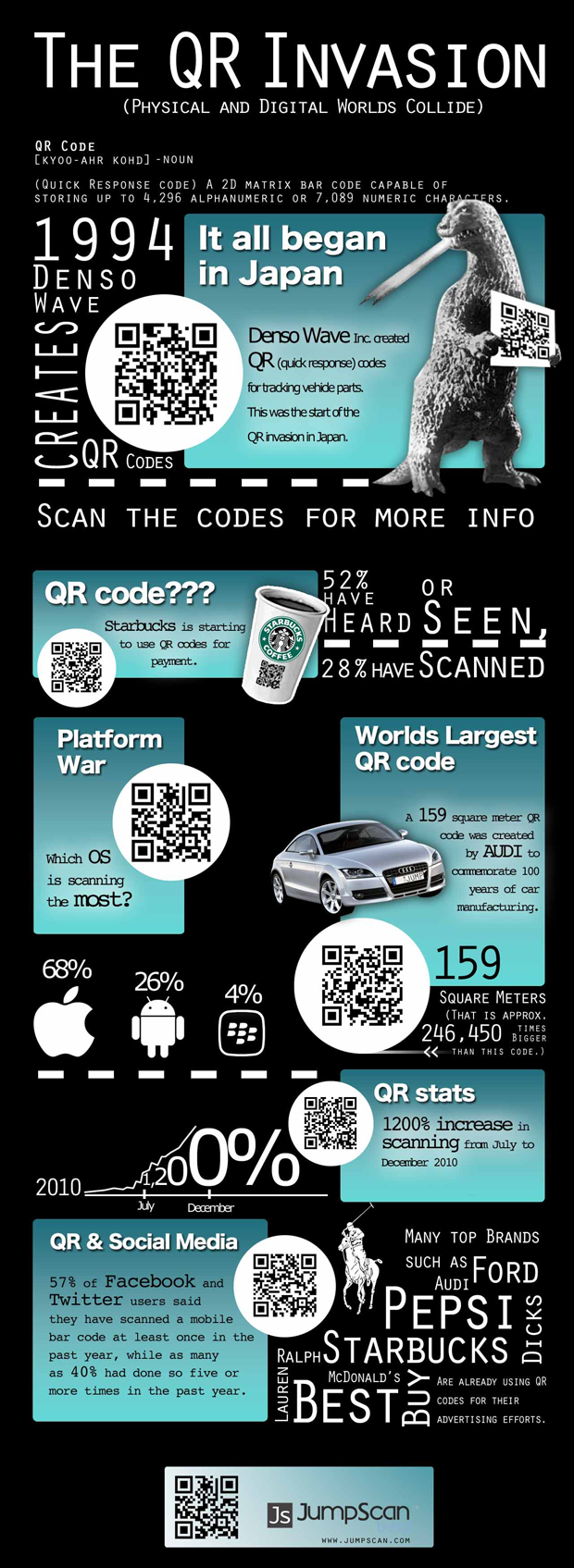

Un código BIDI no es un código QR, aunque lo diga el ministro Montoro

Hoy Cristóbal Montoro presentaba por primera vez unos Presupuestos Generales del Estado, por cierto muy dolorosos, sin utilizar una gran cantidad de papel. Llegaba con una cartulina sobre la que había pegado un pendrive o memoria auxiliar portátil y un código “BIDI”, según el propio Ministerio de Hacienda y la prensa.

Pues bien, con un poco menos de dolor que al ver el contenido de los presupuestos, tenemos que señalar que lo que el Ministro de Hacienda enseñaba en realidad no era un código BIDI, sino un código QR. En este punto, cabe responder a una pregunta: ¿cuál es la diferencia entre un código BIDI y un código QR?

Los códigos QR y los BIDI tienen muchas semejanzas. Pero se diferencian en tres aspectos fundamentales:

Uno: BIDI se genera con un algoritmo de código cerrado, privado y no gratuito. Movistar, Vodafone y Orange tienen licencia para su explotación en España y se necesita la aplicación que ellos proporcionan para poder leerlos, no siempre de forma gratuita. Moraleja: si quieres llegar a más gente, mejor un código QR.

Dos: al ser un código cerrado, no lo puede generar cualquiera. Es decir, tienes que pagar. La empresa Scanlife se ocupa de esto, así como de la descarga de aplicaciones de pago. Moraleja: te cuesta dinero y no llegas a tantos.

Tres: los códigos QR almacenan más información que los BIDI. Moraleja: puedes usarlos para textos pequeños (URLs) o para cosas muy grandes (mensajes de texto o emails).

¿Cómo diferenciarlos cuando los veo?

Los códigos QR se diferencian por tener tres cuadrados más grandes en tres de sus esquinas. Los BIDI no los tienen.

Ampliar en: Creatividad QR

¿Cómo la física cuántica podría hacer ‘The Matrix’ más eficiente?

Las simulaciones cuánticas necesitan almacenar menos información para predecir el futuro que las simulaciones clásicas. El hallazgo se aplica a fenómenos descritos por procesos estocásticos.

Los investigadores han descubierto una nueva forma en la que las computadoras basadas en la física cuántica podrían superar el rendimiento de los ordenadores clásicos. El trabajo, realizado por investigadores con sede en Singapur y el Reino Unido, implica que una simulación de la realidad tipo Matrix, requiere menos memoria en una computadora cuántica que en un ordenador clásico. También alude a una forma de investigar si una teoría más profunda se encuentra por debajo de la teoría cuántica. El hallazgo se publicó el 27 de marzo en Nature Communications.

El hallazgo surge de la consideración fundamental de la cantidad de información que se necesita para predecir el futuro. Milla Gu, Elisabeth Rieper y Vedral Vlatko en el Centro de Quantum Technologies en la Univesidad Nacional de Singapur, con Karoline Wiesner de la Universidad de Bristol, Reino Unido, consideran la simulación de procesos de tipo «estocástico», donde hay varios resultados posibles a un determinado procedimiento, cada uno ocurre con una probabilidad calculable. Muchos de los fenómenos, desde los movimientos del mercado de valores a la difusión de los gases, se pueden modelar como procesos estocásticos.

Los detalles de cómo simular estos procesos dan lugar a una gran cantidad de investigadores ocupados. La cantidad mínima de información necesaria para simular un proceso estocástico dado es un tema importante de estudio en el campo de la teoría de la complejidad, que se conoce en la literatura científica como la complejidad estadística.

Los investigadores saben cómo calcular la cantidad de información transferida por sí en cualquier proceso estocástico. En teoría, esto establece la cantidad mínima de información necesaria para simular el proceso. En realidad, sin embargo, las simulaciones clásicas de los procesos estocásticos requieren más espacio de almacenamiento que esto.

Gu, Wiesner, Rieper y Vedral, quien también está afiliado a la Universidad de Oxford, Reino Unido, mostró que los simuladores cuánticos necesitan almacenar menos información que los simuladores clásicos óptimos. Eso es porque las simulaciones cuánticas pueden codificar la información acerca de las probabilidades en una «superposición», donde un bit cuántico de información puede representar más de un bit clásico.

Lo que sorprendió a los investigadores es que las simulaciones cuánticas todavía no son tan eficientes como podrían ser: todavía tienen que almacenar más información que el proceso parece necesitar. Eso sugiere que la teoría cuántica aún no puede ser optimizada. «Lo que es fascinante para nosotros es que todavía hay una brecha. Te hace pensar, tal vez esta es una manera de pensar acerca de una teoría más allá de la física cuántica», dice Vedral.

Fuente: «Quantum mechanics can reduce the complexity of classical models» Nature Communications, 3, 762 (2012).http://www.nature. … mms1761.html

Preprint en: arXiv:1102.1994 http://arxiv.org/abs/1102.1994

Internet y el anti-conocimiento

Empiezo a estar un poco “mosca” con este mantra que se repite hasta la saciedad: en internet está todo. ¡Pues no! Sí hay muchas cosas, sobre todo en inglés, pero no está todo. Y aunque fuera así, ¿por qué creemos que eso es bueno? Piénselo un momento: ¿Tener acceso a cualquier cosa es lo mejor que nos puede suceder? Yo estoy con Radio Futura cuando cantaban aquello de “David Bowie lo sabe y tu mami también / hay cosas en la noche que es mejor no ver”.

Dicen que con Internet hemos entrado en la era de la información, y es verdad. Incluso se han inventado un término, infoxicación, para definir un mal de nuestros tiempos: nos llega más información de la que podemos procesar y eso nos crea angustia. Un estudio realizado en 2002 por Peter Lyman y Hal Varian de la Universidad de Berkeley reveló que la información producida ese año equivalía a medio millón de nuevas bibliotecas, cada una conteniendo la versión digitalizada de las colecciones impresas de la mayor biblioteca del mundo, la Biblioteca del Congreso norteamericano.

A los santificadores de internet se les llena la boca con tales datos y sacan pecho; solo les falta decir que Internet es lo mejor que ha parido madre. Y podría ser así, pero olvidan una cosa fundamental: la información no es conocimiento. Y lo que hace progresar al ser humano es esto último.

El conocimiento exige tiempo y tranquilidad de espíritu para poder asimilar la información en condiciones, todo lo contrario a lo que sucede en esta época de Facebook y Twitter. Estos medios, con todas sus bondades, nos están llevando a una sociedad de conocimiento débil: ya no soportamos complejos razonamientos, sutiles argumentaciones que excedan de los 140 caracteres. Dicen que Internet hace que la gente lea más, pero es un argumento engañoso. Leer es un proceso en tres fases: hacerlo, entender lo que lees y finalmente digerirlo. Internet está promocionando la lectura rápida, mal entendida y regurgitada sin asimilar. Leemos algo y acto seguido contestamos con lo primero que nos viene a la cabeza. Claro que a lo mejor eso no es tan malo, que ya lo decía Jacinto Benavente: “cuando se habla sin pensar se dice lo que se piensa”

Autor: Miguel Ángel Sabadell

(Publicado en Muy Interesante)

El Minitel francés, dejará de prestar servicio en 2012

Minitel, el pionero servicio telemático francés que se anticipó al uso popular de Internet, tiene los días contados. France Telecom, que lo lanzó en 1982, ha decidido cerrar definitivamente el servicio el 30 de junio de 2012. Se trata del tercer anuncio de este tipo ya que la compañía planeó inicialmente desconectarlo en 2010 y posteriormente aplazó la decisión a 2011. Ahora, la fecha parece definitiva,

El apogeo de Minitel data de 1990 cuando tuvo nueve millones de usuarios y 25.000 servicios. En Facebook hay un pequeño grupo de un centenar de miembros que reivindica su salvación.

En 2010, 950.000 franceses consultaban los servicios de Minitel y 810.000 todavía poseían el aparato. La simplicidad de su manejo y la ausencia de virus han sido dos factores que siempre han destacado quienes persisten en utilizarlo.

Su caída ha repercutido en los ingresos de la operadora, que en 2007 ingresaba 100 millones de euros por Minitel. En 2010, la cifra bajó a 200.000. La compañía ha asegurado que Minitel se dirige irremediablemente a su final ya que es totalmente obsoleto. En la actualidad hay activos unos 1.880 servicios.

El servicio x25, código usado por los técnicos para identificar la red que hace funcionar Minitel, se dirige hacia una muerte natural, han asegurado en la operadora.

Minitel ofrecía desde juegos a consulta de horarios o tráfico a mensajería. Muchas compañías ya había abandonado su empleo como Air France, SNCF y tampoco se podían consultar datos como, por ejemplo, las notas del bachillerato.

Fuente: ElPaís.com

El cerebro tiene una capacidad de memoria de 500 petabytes y de procesamiento de un exaflops

¿Cómo se puede llegar a las sorprendentes cifras de que la memoria del cerebro es de 500 petabytes y la capacidad de proceso de un exaflops? Especulando y realizando múltiples supuestos. El resultado es una estimación que puede estar errada en varios órdenes de magnitud. Expongo el razonamiento para que cada cual saque sus conclusiones.

Grandes números.

La primera estimación es la del número de neuronas en el cerebro. El dato más repetido en la red es 10 000 000 000 (10^11). Considero equivalente cerebro y encéfalo (brain en inglés) y que incluye todas las estructuras dentro del cráneo como el cerebelo y el córtex (que solo representa 1/5 parte del cerebro).

El número de sinapsis es también una estimación. Una neurona puede tener hasta 100 000 sinapsis. La media está entre 5 000 y 10 000. Considero para el cálculo 5 000 sinapsis por neurona. El número total de sinapsis, es de 500 000 000 000 000 (10^14*5).

Neuronas Integrate&Fire y neuronas biológicamente realistas.

Las simulaciones utilizan dos tipos de neuronas. La mayoría de ellas usan un modelo Integrate&Fire. Se trata de una neurona sin representación espacial que integra la entrada que proviene de otras neuronas y decide dispararse o no. Es un modelo válido para múltiples casos y el más utilizado. De otro lado están las neuronas biológicamente realistas. Estas usan una representación tridemensional y computan lo que ocurre en cada segmento de la neurona: dendritas, cuerpo y axón. Sus necesidades computacionales son 10 000 veces superiores que las Integrate&Fire.

Estimaciones

El proyecto Blue Brain usa neuronas realistas. Henry Markham estima que la memoria necesaria para simular el cerebro es 500 petabytes y la capacidad de cómputo es de un exaflops. Como se verá, esta es la estimación que considero más realista.

Dharmendra S. Modha ha realizado una simulación con neuronas Integrate&Fire de la que se pueden extrapolar datos. Uno de ellos es que necesita 16 bytes por sinapsis para que la simulación sea operativa. Modha habla solo del córtex y de 10 000 sinapsis por neurona. Su predicción es que se necesitan cuatro petabytes (4 000 000 000 000 000) de memoria y un exaflops (1 000 000.000 000 000 000) de capacidad de proceso. Corregido el dato de memoria, mi primera aproximación es de ocho petabytes:

Se trata de neuronas Integrate&Fire, es decir, de neuronas simplificadas. ¿Podemos simular la expresión de los genes o la proximidad a otras neuronas? No podemos. Dado que las necesidades computacionales son 10 000 mayores en las biológicamente realistas, el cálculo arroja la cifra de: Memoria = 80 exabytes (80 000 000 000 000 000000). Muy lejos de la estimación de Modha y también de la de Markham (aunque solo 160 veces más). Dado que este último ya usa neuronas realistas, considero válida su cifra de:

Memoria = 500 petabytes (500 000 000 000 000 000)

Ampliar en: Sinapsis

Bajo licencia Creative Commons

Cada persona recibe en un día información equivalente a 174 periódicos

Cada persona recibe de media a diario en el mundo un volumen de información equiparable al contenido de 174 periódicos, según un estudio de la Universidad de California del Sur publicado en «Science«.?

En 1986, cuando aún no se había popularizado internet ni el correo electrónico, y el común de los mortales no imaginaba siquiera el nacimiento de Twitter, Facebook o los «smartphones», ese volumen de información rondaba una cantidad equiparable a 40 diarios impresos.

Cada día, una persona envía información a través de datos o imágenes en un tamaño que necesitaría el espacio de seis rotativos, 200 veces más que las dos páginas y media de hace un cuarto de siglo. ?La capacidad del mundo para almacenar la información ha crecido un 28 por ciento anual desde 1986, mientras que la capacidad de transmisión de datos ha subido un seis por ciento anual.

Hace una década, el 75% de la información guardada en todo el planeta se hallaba en soportes analógicos como papeles, libros y cintas de vídeo. Las tornas han cambiado de forma importante y en 2007, el 94% de los fondos están en formato digital.

Fuente: lainformacion.com

_____________________

Enlace de interés:

– Apuntes Introduccion a la Informática. La Información- GAP. Universidad de Murcia

– Apuntes Introduccion a la Informática. Representación de la información – GAP. Universidad de Murcia

Información que almacena la humanidad

En 2007, la humanidad fue capaz de almacenar 295 trillones de bytes (u octetos) óptimamente comprimidos, comunicar casi dos cuatrillones de megabytes, y llevar a cabo 6,4 billones de MIPS (millón de instrucciones por segundo) en ordenadores de uso general. “Para poner uno de esos números en perspectiva, si esos 295 exabytes de información almacenada fueran guardados en CD-ROMs, la pila de CDs llegaría de la Tierra hasta más allá de la Luna”, explican Martin Hilbert, de la Universidad del Sur de California (EEUU), y Priscila López, de la de la Universitat Oberta de Catalunya (España), investigadores principales de un estudio que se ha publicado en la revista Science.

La capacidad mundial para la telecomunicación bidireccional (internet y redes telefónicas) entre 1986 y 2007 creció un 28 % por año, mientras que la capacidad para la difusión de información unidireccional a través de canales de transmisión como la televisión y la radio creció un 6 % anual. «Sin embargo, esta cantidad de información es todavía más pequeña que el número de bits almacenados en todas las moléculas de ADN de un solo adulto humano”, afirman los expertos.

Los resultados rmuestran que mientras que en el año 2000 el 75 % de nuestra información almacenada estaba en formato analógico (principalmente en video cassettes), el 94 % de la información estaba en formato digital en 2007. De su estudio se deduce que 2002 podría considerarse el comienzo de la era digital, ya que fue el primer año en que la capacidad de almacenaje digital superó la capacidad analógica. Además, los datos revelan que las personas compartieron 65 exabytes de información en 2007 por medio de sistemas de comunicación de doble vía como teléfonos móviles, una cantidad equivalente a que cada persona en el mundo comunicara diariamente el contenido de seis periódicos.

Fuente: Muy Interesante

autobus las palmas aeropuerto cetona de frambuesa