Actualidad informática

Noticias y novedades sobre informática

Viendo la próxima dimensión de los chips de ordenador

Una colaboración de investigación entre la Universidad de Osaka y el Instituto de Ciencia y Tecnología de Nara utilizó por primera vez la microscopía de barrido en túnel (STM) para crear imágenes de superficies laterales atómicamente planas de cristales de silicio 3D. Este trabajo ayuda a los fabricantes de semiconductores a seguir innovando y, al mismo tiempo, produce chips de ordenador más pequeños, rápidos y eficientes energéticamente para ordenadores y teléfonos inteligentes.

Una colaboración de investigación entre la Universidad de Osaka y el Instituto de Ciencia y Tecnología de Nara utilizó por primera vez la microscopía de barrido en túnel (STM) para crear imágenes de superficies laterales atómicamente planas de cristales de silicio 3D. Este trabajo ayuda a los fabricantes de semiconductores a seguir innovando y, al mismo tiempo, produce chips de ordenador más pequeños, rápidos y eficientes energéticamente para ordenadores y teléfonos inteligentes.

Nuestros ordenadores y teléfonos inteligentes están cargados con millones de pequeños transistores. La velocidad de procesamiento de estos dispositivos ha aumentado dramáticamente con el paso del tiempo a medida que aumenta el número de transistores que pueden caber en un solo chip de ordenador. Basado en la Ley de Moore, el número de transistores por chip se duplicará cada dos años, y en esta área parece que se mantiene. Para mantener este ritmo de rápida innovación, los fabricantes de ordenadores están continuamente en busca de nuevos métodos para hacer que cada transistor sea cada vez más pequeño.

Los microprocesadores actuales se fabrican añadiendo patrones de circuitos a las obleas de silicio plano. Una forma novedosa de crear más transistores en el mismo espacio es fabricar estructuras 3D. Los transistores de efecto de campo de tipo aleta (FET) se denominan así porque tienen estructuras de silicio parecidas a las aletas que se extienden hacia el aire, fuera de la superficie del chip. Sin embargo, este nuevo método requiere un cristal de silicio con superficies superiores y laterales perfectamente planas, en lugar de sólo la superficie superior, como ocurre con los dispositivos actuales. El diseño de la próxima generación de chips requerirá nuevos conocimientos sobre las estructuras atómicas de las superficies laterales.

Ahora, investigadores de la Universidad de Osaka y del Instituto de Ciencia y Tecnología de Nara informan que han utilizado STM para visualizar por primera vez la superficie lateral de un cristal de silicio. STM es una técnica poderosa que permite ver la ubicación de los átomos de silicio individuales. Al pasar una punta afilada muy cerca de la muestra, los electrones pueden saltar a través de la separación y crear una corriente eléctrica. El microscopio monitoreó esta corriente y determinó la ubicación de los átomos en la muestra.

«Nuestro estudio es un gran primer paso hacia la evaluación de transistores con resolución atómica diseñada para obtener formas tridimensionales», dice la coautora del estudio Azusa Hattori.

Para hacer que las superficies laterales sean lo más suaves posible, los investigadores primero trataron los cristales con un proceso llamado ataque de iones reactivos. El coautor Hidekazu Tanaka dice: «Nuestra habilidad de mirar directamente las superficies laterales usando STM demuestra que podemos hacer estructuras artificiales en 3D con superficies atómicas casi perfectas».

Ampliar en: Solid State TECHNOLOGY

Tesla está trabajando en su propio chip de AI para autoconducción

Tesla está desarrollando su propio procesador para inteligencia artificial, destinado a ser utilizado con sus sistemas de autocontrol, en asociación con AMD. Tesla tiene una relación ya existente con Nvidia, cuyas GPU alimentan su sistema de piloto automático, pero este nuevo chip interno podría reducir su dependencia del hardware de procesamiento de IA de terceros.

AMD ayudaría a Tesla con el desarrollo del chip. Aparentemente, el fabricante de autos eléctricos ya ha recibido las primeras muestras del prototipo de su procesador para probar, según el informe. La construcción de un chip específico diseñado enteramente para la conducción autónoma ayudaría a Tesla de varias maneras, incluyendo un mayor control sobre un aspecto clave de su propia cadena de suministro, y el aumento de la eficiencia general del sistema y el rendimiento.

Tesla ha afirmado que sus vehículos de la generación actual tienen todo el hardware y la capacidad de computación a bordo para lograr la autoconducción completa con una actualización de software en el futuro. Pero la compañía también está siempre iterando en su hardware, evitando las actualizaciones tradicionales de los fabricantes tradicionales de automóviles.

El departamento de pilotaje automático de Tesla está a cargo de Jim Keller, que anteriormente había pasado gran parte de su carrera en AMD, y luego en Apple, donde ayudó a diseñar los procesadores internos A4 y A5 de Apple. El papel clave de Keller en la compañía probablemente habría influido en el fabricante de automóviles para que se propusiera adquirir su propio diseño de procesador y alinear más estrechamente sus componentes de software de autocontrol y computación de hardware.

Antiguo megaprocesador

Casi todo lo que es genial sobre la tecnología de hoy es gracias al microprocesador. Miles de millones de ellos se fabrican cada año y son una de las muchas razones por las que puede leer esta web. Pero pocas personas entienden lo que está pasando dentro de ese pequeño circuito integrado. Vamos con un curso acelerado.

La gente del Centro de Informática de Cambridge tiene una máquina de media tonelada que muestra todos los pequeños detalles que ocurren en un microprocesador a un tamaño que es más fácil de inspeccionar. La máquina ha sido apodada The Megaprocessor y su creador, James Newman, nos guía a través de cómo funciona en el vídeo de abajo.

La creación de Newman es lo suficientemente vistosa como para admirarla por sí sola. Usando unos 40000 transistores y 10000 LEDs, la máquina diagrama todas las comunicaciones y sistemas numéricos que se están llevando a cabo dentro de un microprocesador, todo ello y como vemos, con el fin de jugar en última instancia a una partida de Tetris.

Nuevo procesador de IBM que simula una red de un millón de neuronas

Tiene el tamaño de un sello de correos, pero en su interior contiene el equivalente a un millón de neuronas con 256 millones de conexiones sinápticas programables. El nuevo chip de IBM da un paso más hacia el objetivo de crear un procesador capaz de simular el funcionamiento del cerebro humano.

TrueNorth, que es como se llama este chip, es un salto cuantitativo impresionante respecto a la primera versión, que solo equivalía a 256 neuronas con 262144 sinapsis programables. De un único núcleo neurosináptico, este proyecto de IBM y el programa DARPA SyNAPSE ha pasado a 4096 núcleos.

Con todo, las cifras son irrisorias en comparación con las de un cerebro humano. Solo en la corteza cerebral tenemos entre 15000 y 33000 millones de neuronas. Cada milímetro cúbico de córtex cerebral contiene aproximadamente 1000 millones de sinapsis.

El reto de la computación cognitiva sigue estando lejos, pero eso no le quita mérito a TrueNorth y, de hecho, demuestra la potencia que tiene esta arquitectura de cara al futuro. Mientras llega el momento en el que tengamos que temer que una inteligencia artificial nos ponga en la lista de especies a extinguir, TrueNorth será especialmente útil para desarrollar dispositivos en los que es importante un funcionamiento similar al del cerebro humano.

Ampliar en: GIZMODO

Computación cognitiva

En poco más de medio siglo de computación el avance en tecnología ha sido gigantesco. Desde que Von Neumann diseñó la arquitectura que lleva su nombre, todos los ordenadores se han construido basados en ella. Gordon Moore estableció la famosa ley que lleva su nombre, la ley de Moore. Según esta ley empírica, cada dos años se duplica el número de transistores en un circuito integrado. Todo esto está basado en la lógica y la física. Y ahí está precisamente uno de los problemas actuales, en la física. En una reciente presentación sobre el esperado chip POWER8, el ponente hizo una broma al respecto: “he preguntado a los físicos y me han confirmado que la física no ha cambiado”. Y es que nos acercamos a la frontera del átomo y no es probable que la ley de Moore se siga cumpliendo.

El otro de los problemas está en la lógica. Como gusta recordar a nuestra presidenta, Virginia Marie “Ginni” Rometty, estamos iniciando la tercera era de la computación. De las tabuladoras pasamos a los ordenadores programables y de ahí a la computación cognitiva. El esfuerzo de programar ordenadores es demasiado costoso, necesitamos otro paradigma, ordenadores que aprendan, computación cognitiva.

¿De dónde podemos aprender? ¿En qué podemos inspirarnos? En el mundo vivo, en la biología.

La neurona, base del sistema nervioso, es un dispositivo muy antiguo. Apareció probablemente en la explosión cámbrica hace la respetable cifra de quinientos millones de años. Es un dispositivo lento comparado con un procesador actual, pero con una gran cantidad de ventajas: conectividad, bajo consumo y plasticidad. El cerebro humano contiene 86000000000 de neuronas que trabajan en paralelo de forma coordinada. Consume apenas 20 watios, lo que una bombilla pequeña (un superordenador muy eficiente como Sequoia de IBM consume siete megawatios, 350000 veces más que el cerebro). Y, sobre todo, tiene plasticidad, aprende.

Fuente: PRIMUM NON NOCERE 2013

Logran romper la clave escuchando el sonido de la CPU con un micrófono

Tres investigadores de la Universidad de Tel Aviv han conseguido romper elalgoritmos RSA de 4096 bits. El método de extracción de claves se basa en escuchar con un micrófono los sonidos que realiza la CPU del equipo atacado mientras trabaja con datos codificados.

El procesador central de cada ordenador emite diferentes sonidos que delatan los procesos que se están ejecutando. Al trabajar con datos codificados, el procesador emite sonidos característicos entre los que se pueden reconocer patrones que corresponden a la clave utilizada para la codificación.

Este «lenguaje» involuntario de las CPUs lo provoca su regulador de voltaje al intentar contrarrestar constantemente los cambios de carga. Eso deja una «huella acústica» de alta frecuencia (de entre 10 y 150 KHz) que se puede aislar aplicando diferentes filtros de sonido.

Los científicos israelís han conseguido capturar las frecuencias chivatas con el micrófono de un smartphone dispuesto a 30 cm del equipo atacado, pero también desde una distancia de 4 metros con un sofisticado micrófono direccional. En ambos casos consiguieron romper la clave tras una hora de escucha.

Fuente: elotrolado

alquiler carrozas gran canaria

oferta de viajes a india

regalos de empresa

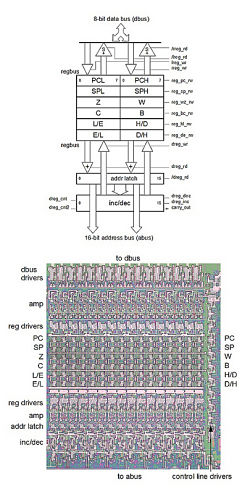

Análisis de ingeniería inversa a los registros del microprocesador 8085

El microprocesador Intel 8085 se fabricó en 1997 y era compatible con el famoso 8080 pero optimizado, para poder crear sistemas más simples y sobre todo baratos.

La conclusión de este análisis revela que los registros del 8085 no son para nada simples almacenes de bits, sino que aparecen muchos trucos interesantes en su implementación que los hacen más rápidos y compactos. También aparecen algunos registros ocultos a los programadores (de uso exclusivamente internos) como el WZ y dos de 8 bits para la ALU: ACT y TMP.

Es increíble que este chip sólo tiene 40 patillas para comunicarse con el mundo exterior, comparado con las más de 1000 de los procesadores actuales.

Análisis que puedes ver al completo aquí y que vimos en HackerNews.

Fuente: CyberHades

Copyleft

Crean una supercomputadora con 64 placas de bajo coste Raspberry Pi y piezas de Lego

Ingenieros informáticos de la Universidad de Southampton (Inglaterra) han construido un superordenador a base de 64 computadoras de bajo coste Raspberry Pi y de piezas de Lego.

El equipo, dirigido por el profesor Simon Cox, estaba formado por Richard Boardman, Everett Andy, Steven Johnston, Kaiping Gereon, Neil O’Brien, Scott Mark y Pergamino Oz, y el hijo de Cox, James (de seis años), que proporcionó apoyo especializado en relación a Lego y en tests del sistema.

«Tan pronto como fuimos capaces de reunir suficientes computadoras Raspberry Pi («Frambuesa Pi»), quisimos ver si era posible unirlas en una supercomputadora. Hemos publicado una guía para que todo el mundo pueda construir su propia computadora «, explica Simon Cox.

«El equipo quiere ver este sistema de bajo coste como un punto de partida para inspirar y permitir a los estudiantes aplicar computación de alto rendimiento y manejo de datos para hacer frente a complejos retos científicos y de ingeniería», añade.

Ampliar en; Alpha Galileo Foundation

CPU DB, sitio con información sobre los microprocesadores

Se trata de un sitio en el cual podemos utilizar su buscador si conocemos el modelo exacto, o bien navegar entre las diferentes familias y microarquitecturas en las cuales todos ellos están clasificados. Y que nos ofrece información relevante acerca de cada modelo, como su cache, velocidad de reloj, cantidad de núcleos, de transistores, voltaje de funcionamiento y varios parámetros más, todo lo cual puede sernos de utilidad si entre otras cosas estamos por hacer oveclocking de nuestro CPU.

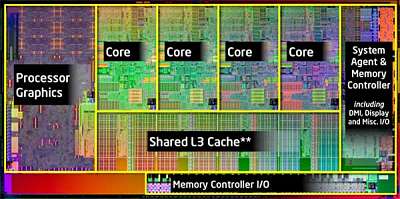

Actualización sobre Ivy Bridge, los procesadores de cuatro núcleos de Intel

Intel ha presentado su nueva gama de chips de cuatro núcleos Ivy Bridge para equipos de sobremesa y portátiles. La arquitectura específica del chip asociado con una tecnología de 22 nanómetros da aumento de autonomía y rendimiento del 20%. Los procesadores de doble núcleo y las versiones de baja potencia para ultrabooks saldrán antes del verano.

El programa incluye trece modelos de procesadores de de Intel familias Quad Core Core i7 y Core i5 . Dirigidas a las computadoras de escritorio (Mac y PC) y portátiles.

Hace casi un año, ya se había discutido los detalles de la tecnología incorporada en el puente de la hiedra, incluyendo su arquitectura Tri-Gate. Ello permitirá un aumento en el número de transistores en los chips tallados en relieve. Así, en este rango, el Extreme Edition i7-3920XM aumentó a 3,5 MHz, contiene 1.4 millones de transistores en una superficie de 160 mm ², contra 1.16 millones de transistores de 214 mm ² de Sandy Bridge, su predecesor . A pesar de este gran salto, la toma que acomoda el procesador en la placa base sigue siendo la misma.

En el futuro, siempre contando con la arquitectura Tri-Gate, Intel todavía tiene que ir más allá en la reducción del tamaño de los circuitos impresios. El objetivo es pasar de una finura de 22 a 14 nanómetros, con una generación de procesadores con nombre Haswell. Con esta combinación, Intel ya ha anunciado una autonomía sorprendente de 24 horas de funcionamiento continuo, que puede extenderse hasta diez días con el modo de reposo cuando el equipo todavía es capaz de recibir e-mails.

Ivy Bridge: 20% de aumento en la autonomía y el rendimiento

Sin embargo, Intel tuvo que modificar la mejora del rendimiento, que anunció hace un año. En lugar de «32% de mejor», se ha pasado al 20%. Una cifra que aún está pendiente. Y el 20%, es también el aumento de la autonomía, en comparación con la generación anterior de 32 nm.

Para ahorrar energía, el chip se adapta su velocidad según sea necesario, incluso si el trabaja sólo en uno de los núcleos cuando otros no son necesarios, por ejemplo, en trabajos de oficina, incluso cuando se reproduce un vídeo.

Esta gama Ivy Bridge también ofrece una gran variedad de opciones adicionales. Esto es especialmente cierto con la seguridad con la integración de la tecnología en encriptación de 64 bits sobre la marcha, llamada Secure Key.

¿El principio del fin de las tarjetas gráficas?

Es principalmente en los gráficos donde los esfuerzos de los ingenieros hacen las pruebas. El procesador incorpora un procesador de Swift 3D, las HD 4000 Gaphics, incluyendo un chip que sabe administrar DirectX 11. También es capaz de soportar la visualización simultánea de tres pantallas. Del mismo modo, las videoconferencias pueden ser manejados ahora en el hardware.

Sobre los juegos en 3D, Intel dijo como «el chip gráfico integrado muestra el doble de rendimiento en comparación con la generación anterior.» De hecho, nos preguntamos si con un procesador, una tarjeta gráfica sigue siendo necesaria. Intel nos dijo que «la solución gráfica propuesta permite a los jugadores casuales para tener la mejor experiencia de juego posible, sin necesidad de tarjeta gráfica.» Sin embargo, «para» hardcore gamer «, Intel recomienda siempre usar una tarjeta gráfica dedicada asociado con una gama de procesadores Core i7.»

A raíz del anuncio de la disponibilidad del chip de Intel, los fabricantes están empezando a reconstruir sus rangos. De este modo, Asus presentó una portátil de 15,6 pulgadas (55VD-DS71), con un Core i7 quad 2,3 GHz corazón. Unos días más tarde, Samsung, por su parte, dio a conocer un portátil más grande (17.3 pulgadas), su serie 7 que tendría una duración de batería de 8 horas. También se espera que Apple anuncia el nuevo MacBook Pro e iMac.

Por último, Intel nos dijo que además de este rango de cuatro Ivy Bridge, los procesadores de doble núcleo y las versiones de baja potencia para ultrabook deben salir antes del verano.

Fuente: Futura-Sciences

autobus las palmas aeropuerto cetona de frambuesa