Actualidad informática

Noticias y novedades sobre informática

Flip-flop qubits: Nuevo diseño de computación cuántica radicalmente nuevo

Ingenieros de la Universidad de Nueva Gales del Sur (Australia) han inventado una nueva arquitectura para la computación cuántica, basada en novedosos «qubits de flip-flop», que promete hacer que la fabricación a gran escala de chips cuánticos sea mucho más barata -y más fácil- de lo que se pensaba.

El nuevo diseño del chip, detallado en la revista Nature Communications, permite un procesador cuántico de silicio que puede ampliarse sin necesidad de colocar los átomos con precisión en otros enfoques. Es importante destacar que permite que los bits cuánticos (o «qubits») -la unidad básica de información en un ordenador cuántico- se coloquen a cientos de nanómetros de distancia y permanezcan acoplados.

El diseño fue concebido por un equipo liderado por Andrea Morello, Gerente de Programa en el Centro de Excelencia ARC para Computación Cuántica y Tecnología de la Comunicación (CQC2T) con sede en Sydney, UNSW, quien dijo que la fabricación del nuevo diseño debe estar fácilmente al alcance de la tecnología actual.

El autor principal Guilherme Tosi, investigador asociado del CQC2T, desarrolló el concepto pionero junto con Morello y los coautores Fahd Mohiyaddin, Vivien Schmitt y Stefanie Tenberg del CQC2T, junto con los colaboradores Rajib Rahman y Gerhard Klimeck de la Universidad Purdue en los Estados Unidos.

«Es un diseño brillante, y como muchos saltos conceptuales, es increíble que nadie lo haya pensado antes», dijo Morello.

«Lo que Guilherme y el equipo han inventado es una nueva forma de definir un ‘spin qubit’ que utiliza tanto el electrón como el núcleo del átomo. Crucialmente, este nuevo qubit puede ser controlado usando señales eléctricas, en lugar de señales magnéticas. Las señales eléctricas son significativamente más fáciles de distribuir y localizar en un chip electrónico».

Tosi dijo que el diseño elude un reto que se espera que enfrenten todos los qubits de silicio basados en el spin a medida que los equipos comienzan a construir conjuntos de qubits cada vez más grandes: la necesidad de espaciarlos a una distancia de sólo 10-20 nanómetros, o solo 50 átomos de separación.

«Si están demasiado cerca o demasiado lejos, el ‘entrelazamiento’ entre bits cuánticos -que es lo que hace que las computadoras cuánticas sean tan especiales- no ocurre», dijo Tosi.

Los investigadores de la UNSW ya lideran el mundo en la fabricación de qubits en esta escala, dijo Morello. «Pero si queremos hacer un arsenal de miles o millones de qubits tan cerca, significa que todas las líneas de control, la electrónica de control y los dispositivos de lectura deben fabricarse también en esa escala nanométrica, y con ese paso y esa densidad de electrodos. Este nuevo concepto sugiere otro camino.»

En el otro extremo del espectro se encuentran los circuitos superconductores – perseguidos, por ejemplo, por IBM y Google – y las trampas de iones. Estos sistemas son grandes y fáciles de fabricar, y actualmente están liderando el camino en el número de qubits que pueden ser operados. Sin embargo, debido a sus dimensiones más grandes, a largo plazo pueden enfrentar desafíos cuando intentan ensamblar y operar millones de qubits, como lo requieren los algoritmos cuánticos más útiles.

«Nuestro nuevo enfoque basado en silicio se encuentra justo en el punto ideal», dijo Morello, profesor de ingeniería cuántica de la UNSW. «Es más fácil de fabricar que los dispositivos a escala atómica, pero aún así nos permite colocar un millón de qubits en un milímetro cuadrado».

En el qubit de un solo átomo utilizado por el equipo de Morello, y que aplica el nuevo diseño de Tosi, se cubre un chip de silicio con una capa de óxido de silicio aislante, sobre cuya parte superior se apoya un patrón de electrodos metálicos que funcionan a temperaturas cercanas al cero absoluto y en presencia de un campo magnético muy fuerte.

El núcleo central es un átomo de fósforo, del cual el equipo de Morello ha construido previamente dos qubits funcionales utilizando un electrón y el núcleo del átomo. Estos qubits, tomados individualmente, han demostrado tiempos de coherencia de récord mundial.

El avance conceptual de Tosi es la creación de un tipo de qubit completamente nuevo, utilizando tanto el núcleo como el electrón. En este enfoque, se define un estado «0» cuando el giro del electrón está hacia abajo y el giro del núcleo hacia arriba, mientras que el estado «1» es cuando el giro del electrón está hacia arriba, y el giro nuclear está hacia abajo.

«Lo llamamos el qubit’ flip-flop'», dijo Tosi. «Para operar este qubit, hay que extraer el electrón un poco del núcleo, usando los electrodos de la parte superior. Al hacerlo, también creas un dipolo eléctrico.»

«Este es el punto crucial», añade Morello. «Estos dipolos eléctricos interactúan entre sí a distancias bastante grandes, una buena fracción de un micrón o 1000 nanómetros.

«Esto significa que ahora podemos separar mucho más los qubits de un solo átomo de lo que antes se creía posible», continuó. «Así que hay mucho espacio para intercalar los componentes clásicos clave como interconexiones, electrodos de control y dispositivos de lectura, manteniendo la naturaleza atómica precisa del bit cuántico».

Morello calificó el concepto de Tosi de tan significativo como Bruce Kane, el seminal artículo de 1998 en Nature. Kane, luego investigador asociado senior de la UNSW, se topó con una nueva arquitectura que podría hacer realidad un ordenador cuántico basado en silicio, lo que desencadenaría la carrera de Australia.

«Como en el trabajo de Kane, ésta es una teoría, una propuesta: el qubit aún no se ha construido», dijo Morello. «Tenemos algunos datos experimentales preliminares que sugieren que es totalmente factible, así que estamos trabajando para demostrarlo. Pero creo que esto es tan visionario como el trabajo original de Kane».

La construcción de un ordenador cuántico se ha denominado la «carrera espacial del siglo XXI», un reto difícil y ambicioso con el potencial de entregar herramientas revolucionarias para hacer frente a cálculos que de otro modo serían imposibles, con una plétora de aplicaciones útiles en el sector sanitario, la defensa, las finanzas, la química y el desarrollo de materiales, la depuración de software, el sector aeroespacial y el transporte. Su velocidad y poder radican en el hecho de que los sistemas cuánticos pueden albergar múltiples «superposiciones» de diferentes estados iniciales, y en el espeluznante «enredo» que sólo ocurre a nivel cuántico las partículas fundamentales.

«Se necesitará una gran ingeniería para llevar la computación cuántica a la realidad comercial, y el trabajo que vemos en este extraordinario equipo pone a Australia en el asiento del conductor», dijo Mark Hoffman, Decano de Ingeniería de la UNSW. «Es un gran ejemplo de cómo la UNSW, al igual que muchas de las universidades de investigación más importantes del mundo, se encuentra hoy en el corazón de un sofisticado sistema de conocimiento global que está dando forma a nuestro futuro».

El equipo de la UNSW ha llegado a un acuerdo de 83 millones de dólares australianos entre la UNSW, el gigante de las telecomunicaciones Telstra, el Commonwealth Bank de Australia y los gobiernos de Australia y Nueva Gales del Sur para desarrollar, para el año 2022, un prototipo de circuito integrado cuántico de silicio de 10 bits, el primer paso en la construcción de la primera computadora cuántica del mundo en silicio.

En agosto, los socios lanzaron Silicon Quantum Computing Pty Ltd., la primera empresa de computación cuántica de Australia, para avanzar en el desarrollo y comercialización de las tecnologías únicas del equipo. El Gobierno de Nueva Gales del Sur prometió 8,7 millones de dólares australianos, 25 millones de dólares de los EE. UU., 14 millones de dólares australianos para el Banco del Commonwealth, 10 millones de dólares australianos para Telstra y 25 millones de dólares australianos para el Gobierno federal.

Ampliar en: EurekAlert!

Cómo una tarjeta MicroSD puede almacenar hasta 400GB de datos

El 31 de agosto de 2017 la empesa SanDisk anunció una tarjeta microSD de gran capacidad de almacenamiento, capaz de introducir 400 GB de datos en ella. ¡Eso es correcto! Una tarjeta de memoria del tamaño de un centavo puede almacenar unas increíbles 40 horas de vídeo 1080p en bruto, algo que era absolutamente incomprensible para los expertos en tecnología hace apenas una década. Pero, ¿es este realmente el límite superior? ¿Hemos llegado a la memoria máxima? ¿O podemos encajar aún más en este pequeño espacio de cinco milímetros cuadrados?

Un problema teórico

Medio centímetro no le da mucho espacio, y los dispositivos que se fabrican para tarjetas microSD no pueden volver a ser utilizados para otra cosa. Esto significa que tendrás que trabajar dentro de estas limitaciones. Por lo general, los fabricantes de tarjetas como SanDisk reducirían el tamaño de sus transistores para que quepan más de ellos en un espacio minúsculo. En 2013 este tamaño era de aproximadamente 19 nm. Una lámina de estos transistores dentro de un espacio de medio centímetro daría 8 GB de espacio de almacenamiento, que era abundante para la mayoría de los dispositivos de consumo a pequeña escala.

Para hacer que más memoria quepa en la misma cantidad de espacio, necesitaría apilar los transistores uno encima del otro, creando capas de transistores que doblarían o cuadruplicarían la cantidad de espacio de almacenamiento disponible. Así es como empezaron a aparecer las tarjetas microSD con capacidades de 32 GB. Llega un momento en el tiempo, sin embargo, donde las cosas se ponen un poco demasiado cómodas y tienes que empezar a comer en el marco para encajar más capas.

En el nivel de 19 nm, se necesitarían ocho capas de transistores para ajustar 64 GB de memoria. Para encajar 400 GB, se necesitarían exactamente cincuenta capas. Aunque esto es teóricamente posible, es extraordinariamente difícil de hacer en un espacio tan reducido.

Cuando no hay otra opción que doblar la apuesta

Ya hemos discutido el hecho de que no es posible cambiar las dimensiones de cada ranura en cada dispositivo para que quepa una tarjeta más grande. La única opción que queda es sumergirse aún más en la tecnología de fabricación de microtransistores. ¡Tenemos que hacerlos más pequeños!

Teóricamente, un transistor podría ser tan pequeño como una sola molécula. El 14 de agosto, hemos conseguido hacer transistores de molécula única que funcionaban de forma sostenible a temperatura ambiente. Debido a que el proceso de hacerlas es tan complicado, no podemos esperar que se conviertan en algo dominante en el futuro, pero presentan una ventana a lo que parece el futuro. Pronto veremos transistores de tan sólo 5 nm.

Recuerde, los transistores caben en un espacio tridimensional, lo que significa que a medida que se hacen más pequeños, también se obtiene más espacio para apilarlos. Esto es lo que debe haber sucedido para que SanDisk sea capaz de crear una tarjeta microSD de 400 GB. Bajo la especificación de transistores de 10 nm disponible para los fabricantes a partir de 2017, puede ajustar 400 GB de memoria utilizando 25 capas de transistores, ahora pueden caber aproximadamente 16 GB por capa.

Con los transistores de 5 nm, podríamos terminar creando tarjetas microSD que se ajusten a un terabyte de memoria, que es aproximadamente donde veo el límite. Puede que no seamos capaces de superar ese nivel y probablemente ni siquiera lo necesitemos en un futuro previsible.

Ampliar en: Maketecheasyer

Los bits se vuelven antiesquirmions

El mundo actual, que cambia rápidamente debido a «big data», está encapsulado en miles de millones de pequeños objetos magnéticos -bits magnéticos- cada uno de los cuales almacena un bit de datos en unidades de disco magnético. Un grupo de científicos de los Institutos Max Planck de Halle y Dresde han descubierto un nuevo tipo de nano-objeto magnético en un material novedoso que podría servir como un bit magnético con propiedades de invisibilidad para hacer realidad en un futuro próximo una unidad de disco magnético sin partes móviles – una memoria Racetrack.

La mayoría de los datos digitales se almacenan en la nube como bits magnéticos dentro de números masivos de unidades de disco magnético. En las últimas décadas, estos bits magnéticos se han reducido en muchos órdenes de magnitud, llegando a límites donde los límites de estas regiones magnéticas pueden tener propiedades especiales. En algunos materiales especiales estos límites – «paredes de dominio magnético» – pueden ser descritos como topológicos. Lo que esto significa es que se puede pensar que estas paredes tienen un manto mágico especial – lo que los científicos llaman «protección topológica». Una consecuencia importante es que tales paredes magnéticas son más estables a las perturbaciones que los bits magnéticos similares sin protección topológica que se forman en materiales magnéticos convencionales. Así pues, estos objetos magnéticos «topológicos» podrían ser especialmente útiles para almacenar «1»y «0»los elementos básicos de los datos digitales.

Uno de estos objetos es un «esqurmión magnético» que es una pequeña región magnética, tal vez de decenas a cientos de átomos de ancho, separado de una región magnética circundante por una pared de dominio quiral. Hasta hace poco solo se ha encontrado un tipo de esqurmión, el que está rodeado por una pared de dominio quiral que toma la misma forma en todas las direcciones. Pero hanbhabido predicciones de varios otros tipos de esqurmiones que aún no se han observado. En un artículo publicado en Nature, científicos del departamento NISE del Prof. Stuart Parkin en el Instituto Max Planck para la Física de Microestructuras en Halle, Alemania, han encontrado una segunda clase de esquirmiones, lo que se llama «antisesquirmiones», en materiales sintetizados en el Departamento de Química de Estado Sólido del Prof. Claudia Felser en el Instituto Max Planck para CPFS, Dresden, Alemania.

Los científicos de Halle y Dresden han encontrado estos diminutos objetos magnéticos en una clase especial de compuestos magnéticos versátiles llamados Heusler que Claudia Felser y sus colegas han explorado extensamente durante los últimos 20 años. De estos compuestos de Heusler, un pequeño subconjunto tiene la simetría cristalina justa para permitir la posibilidad de formar antiesquirmiones pero no sesquirmiones. Utilizando un microscopio electrónico de transmisión altamente sensible en el Instituto Max Planck para Física de Microestructuras, Halle, que fue especialmente modificado para permitir la detección de pequeños momentos magnéticos, se crearon y detectaron antiesquirmiones sobre una amplia gama de temperaturas y campos magnéticos. Y lo que es más importante, los antiesquirmiones, tanto en arreglos ordenados como en objetos aislados, se podían ver incluso a temperatura ambiente y en campos magnéticos cero.

Las propiedades especiales de ocultación de los esquirmiones los hace de gran interés para una forma radicalmente nueva de memoria de estado sólido – Memoria Racetrak – que fue propuesta por Stuart Parkin hace una década. En Racetrack, los datos digitales están codificados dentro de las paredes del dominio magnético, que se encuentran dentro de cables magnéticos nanoscópicos. Una de las características únicas de Racetrack, que es diferente a todas las demás memorias, es que las paredes se mueven alrededor de los nanocables usando descubrimientos recientes en la espin-orbitrónica. Los pulsos muy cortos de corriente mueven todas las paredes del dominio hacia atrás y hacia adelante a lo largo de los nanocables. Las paredes -las puntas magnéticas- pueden ser leídas y escritas por dispositivos incorporados directamente en los propios nanohilos, eliminando así cualquier pieza mecánica. Las paredes magnéticas protegidas topológicamente son muy prometedoras para las memorias Racetrack.

Por lo tanto, los antisesquirmiones podrían aplicarse a las memorias Racetrack pronto. Yendo incluso más allá de los antiesquirmiones el siguiente objetivo es la realización de una tercera clase de esquirmiones – esquirmiones antiferromagnéticos- que son diminutos objetos magnéticos que realmente no tienen ningún momento magnético neto. Son magnéticamente casi invisibles pero tienen propiedades únicas que los hacen de gran interés.

Ampliar en: Ajaya K. Nayak et al, Magnetic antiskyrmions above room temperature in tetragonal Heusler materials, Nature (2017). DOI: 10.1038/nature23466

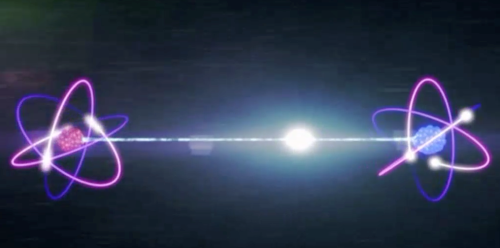

El entrelazamiento es una característica inevitable de la realidad

¿Es realmente necesario el entrelazamiento para describir el mundo físico, o es posible tener alguna teoría post-cuántica sin entrelazamiento?

¿Es realmente necesario el entrelazamiento para describir el mundo físico, o es posible tener alguna teoría post-cuántica sin entrelazamiento?

En un nuevo estudio, físicos han probado matemáticamente que cualquier teoría que tenga un límite clásico -es decir, que pueda describir nuestras observaciones del mundo clásico recuperando la teoría clásica bajo ciertas condiciones- debe contener entrelazamientos. Así que a pesar de que el entrelazamiento va en contra de la intuición clásica, el entrelazamiento debe ser una característica inevitable no sólo de la teoría cuántica, sino también de cualquier teoría no clásica, incluso de las que aún están por desarrollar.

Los físicos, Jonathan G. Richens en el Imperial College London y el University College London, John H. Selby en el Imperial College London y la Universidad de Oxford, y Sabri W. Al-Safi en la Universidad de Nottingham Trent, han publicado un artículo estableciendo el entrelazamiento como una característica necesaria de cualquier teoría no clásica en un número reciente de Physical Review Letters.

«La teoría cuántica tiene muchas características extrañas en comparación con la teoría clásica», dijo Richens a Phys. org. «Tradicionalmente estudiamos cómo el mundo clásico emerge del cuántico, pero nos propusimos revertir este razonamiento para ver cómo el mundo clásico da forma al cuántico. Al hacerlo, demostramos que uno de sus rasgos más extraños, el entrelazamiento, no es nada sorprendente. Esto insinúa que gran parte de la aparente extrañeza de la teoría cuántica es una consecuencia inevitable de ir más allá de la teoría clásica, o tal vez incluso una consecuencia de nuestra incapacidad para dejar atrás la teoría clásica».

Aunque la prueba completa es muy detallada, la idea principal detrás de ella es simplemente que cualquier teoría que describa la realidad debe comportarse como una teoría clásica en algún límite. Este requisito parece bastante obvio, pero como muestran los físicos, imparte fuertes restricciones a la estructura de cualquier teoría no clásica.

La teoría cuántica cumple este requisito de tener un límite clásico a través del proceso de decoherencia. Cuando un sistema cuántico interactúa con el entorno externo, el sistema pierde su coherencia cuántica y todo lo que lo hace cuántico. Así que el sistema se vuelve clásico y se comporta como se espera de la teoría clásica.

Aquí, los físicos muestran que cualquier teoría no clásica que recupere la teoría clásica debe contener estados entrelazados. Para demostrarlo, asumen lo contrario: que tal teoría no tiene entrelazamiento. Entonces demuestran que, sin entrelazarse, cualquier teoría que recupere la teoría clásica debe ser la teoría clásica en sí misma, una contradicción de la hipótesis original de que la teoría en cuestión no es clásica. Este resultado implica que la suposición de que tal teoría no tiene entrelazado es falsa, lo que significa que cualquier teoría de este tipo debe tener entrelazado.

Este resultado puede ser sólo el comienzo de muchos otros descubrimientos relacionados, ya que abre la posibilidad de que otros rasgos físicos de la teoría cuántica puedan reproducirse simplemente exigiendo que la teoría tenga un límite clásico. Los físicos anticipan que características como la causalidad de la información, la simetría de bits y la ubicación macroscópica pueden aparecer como resultado de este único requisito. Los resultados también proporcionan una idea más clara de cómo debe ser cualquier teoría futura no clásica, post-cuántica.

«Mis metas futuras serían ver si la no-localidad de Bell también puede derivarse de la existencia de un límite clásico», dijo Richens. «Sería interesante si todas las teorías que reemplazan a la teoría clásica violaran el realismo local. También estoy trabajando para ver si ciertas extensiones de la teoría cuántica (como la interferencia de orden superior) pueden ser descartadas por la existencia de un límite clásico, o si este límite imparte restricciones útiles a estas’ teorías post-cuántico'».

Ampliar en: Jonathan G. Richens, John H. Selby, and Sabri W. Al-Safi. «Entanglement is Necessary for Emergent Classicality in All Physical Theories.» Physical Review Letters. DOI: 10.1103/PhysRevLett.119.080503

Almacenamiento de datos en imanes del tamaño de un átomo

Hay un dicho que indica que los datos se expandirán hasta llenar toda la capacidad disponible. Tal vez hace diez o veinte años, era común almacenar programas de software, música MP3, películas y otros archivos, que podáin haber sido recopilados durante años. En los días en que las unidades de disco duro ofrecían unas pocas decenas de gigabytes de almacenamiento, la falta de espacio era casi inevitable.

Ahora que tenemos internet de banda ancha rápida y no pensamos en la descarga de un DVD de 4,7 gigabytes, podemos acumular datos aún más rápidamente. Las estimaciones de la cantidad total de datos almacenados en todo el mundo aumentarán de 4,4 billones de gigabytes en 2013 a 44 billones de gigabytes en 2020. Esto significa que estamos generando un promedio de 15 millones de gigabytes al día. A pesar de que las unidades de disco duro ahora se miden en miles de gigabytes en lugar de decenas, todavía tenemos un problema de almacenamiento.

La investigación y el desarrollo se centran en el desarrollo de nuevos medios de almacenamiento de datos que son más densos y por lo que puede almacenar una mayor cantidad de datos, y hacerlo de una manera más eficiente de la energía. A veces esto implica actualizar técnicas establecidas: recientemente IBM anunció una nueva tecnología de cinta magnética que puede almacenar 25 gigabytes por pulgada cuadrada (una pulgada equivale a 2,54 cm), un nuevo récord mundial para la tecnología de 60 años de edad. Mientras que los actuales discos duros magnéticos o de estado sólido son más densos alrededor de 200 gigabytes por pulgada cuadrada, las cintas magnéticas todavía se utilizan con frecuencia para la copia de seguridad de datos.

Sin embargo, la vanguardia de la investigación de almacenamiento de datos está trabajando a nivel de átomos y moléculas individuales, representando el límite máximo de la miniaturización tecnológica.

Búsqueda de los imanes atómicos

Las tecnologías actuales de almacenamiento de datos magnéticos -las utilizadas en los discos duros tradicionales con platos giratorios, estándar hasta hace unos años y que todavía son comunes hoy en día- se basan en métodos «top-down». Esto implica hacer capas delgadas de una gran pieza de material ferromagnético, cada uno conteniendo muchos dominios magnéticos que se utilizan para contener datos. Cada uno de estos dominios magnéticos está hecho de una gran colección de átomos magnetizados, cuya polaridad magnética es establecida por la cabeza de lectura / escritura del disco duro para representar datos como binarios uno o cero.

Un método «ascendente» alternativo implicaría construir dispositivos de almacenamiento colocando átomos o moléculas individuales uno por uno, cada uno capaz de almacenar un solo bit de información. Los dominios magnéticos conservan su memoria magnética debido a la comunicación entre grupos de átomos magnetizados vecinos.

Los imanes de un solo átomo o de una sola molécula por otro lado no requieren esta comunicación con sus vecinos para retener su memoria magnética. En cambio, el efecto de memoria surge de la mecánica cuántica. Por lo tanto, debido a que los átomos o las moléculas son mucho, mucho más pequeños que los dominios magnéticos actualmente utilizados, y pueden usarse individualmente en lugar de en grupos, pueden ser empacados más estrechamente, lo que podría dar lugar a un enorme aumento en la densidad de datos.

Trabajar con átomos y moléculas como éste no es ciencia ficción. Los efectos de la memoria magnética en imanes de una sola molécula (SMMs) se demostró por primera vez en 1993, y efectos similares para los imanes de átomo único se mostraron en 2016.

Aumentar la temperatura

El problema principal que está en el camino de mover estas tecnologías fuera del laboratorio y en la corriente principal es que todavía no trabajan a temperaturas ambiente. Tanto los átomos individuales como los SMM requieren enfriamiento con helio líquido (a una temperatura de -269 ° C), un recurso costoso y limitado. Así, el esfuerzo de investigación durante los últimos 25 años se ha concentrado en elevar la temperatura a la que se puede observar la histéresis magnética, una demostración del efecto de la memoria magnética. Un objetivo importante es -196 ° C, porque esta es la temperatura que se puede lograr con el nitrógeno líquido, que es abundante y barato.

Tomó 18 años para el primer paso sustancial para elevar la temperatura en la que la memoria magnética es posible en SMMs – un aumento de 10 ° C logrado por los investigadores en California. Pero ahora el equipo de investigación en la Escuela de Química de la Universidad de Manchester ha logrado histéresis magnéticas en un SMM a -213 ° C usando una nueva molécula basada en el elemento de tierras raras disprosio, según se informa en una carta a la revista Nature. Con un salto de 56 ° C, esto está a sólo 17 ° C de la temperatura del nitrógeno líquido.

Usos futuros

Sin embargo, hay otros desafíos. Con el fin de almacenar prácticamente bits individuales de datos, las moléculas deben fijarse a las superficies. Esto se ha demostrado con SMMs en el pasado, pero no para esta última generación de SMMs de alta temperatura. Por otra parte, la memoria magnética en átomos individuales ya se ha demostrado en una superficie.

La prueba definitiva es la demostración de la escritura y la lectura no destructiva de datos en átomos o moléculas individuales. Esto ha sido logrado por primera vez en 2017 por un grupo de investigadores de IBM que demostró el dispositivo de almacenamiento de memoria magnética más pequeño del mundo, construido alrededor de un solo átomo.

Sin embargo, independientemente de si los dispositivos de almacenamiento de un solo átomo o de una sola molécula se vuelven verdaderamente prácticos, los avances en la ciencia fundamental que se están realizando a lo largo de este camino son fenomenales. Las técnicas de química sintética desarrolladas por los grupos que trabajan en SMM ahora nos permiten diseñar moléculas con propiedades magnéticas personalizadas, que tendrán aplicaciones en la computación cuántica e incluso la resonancia magnética.

Ampliar en: The Conversation

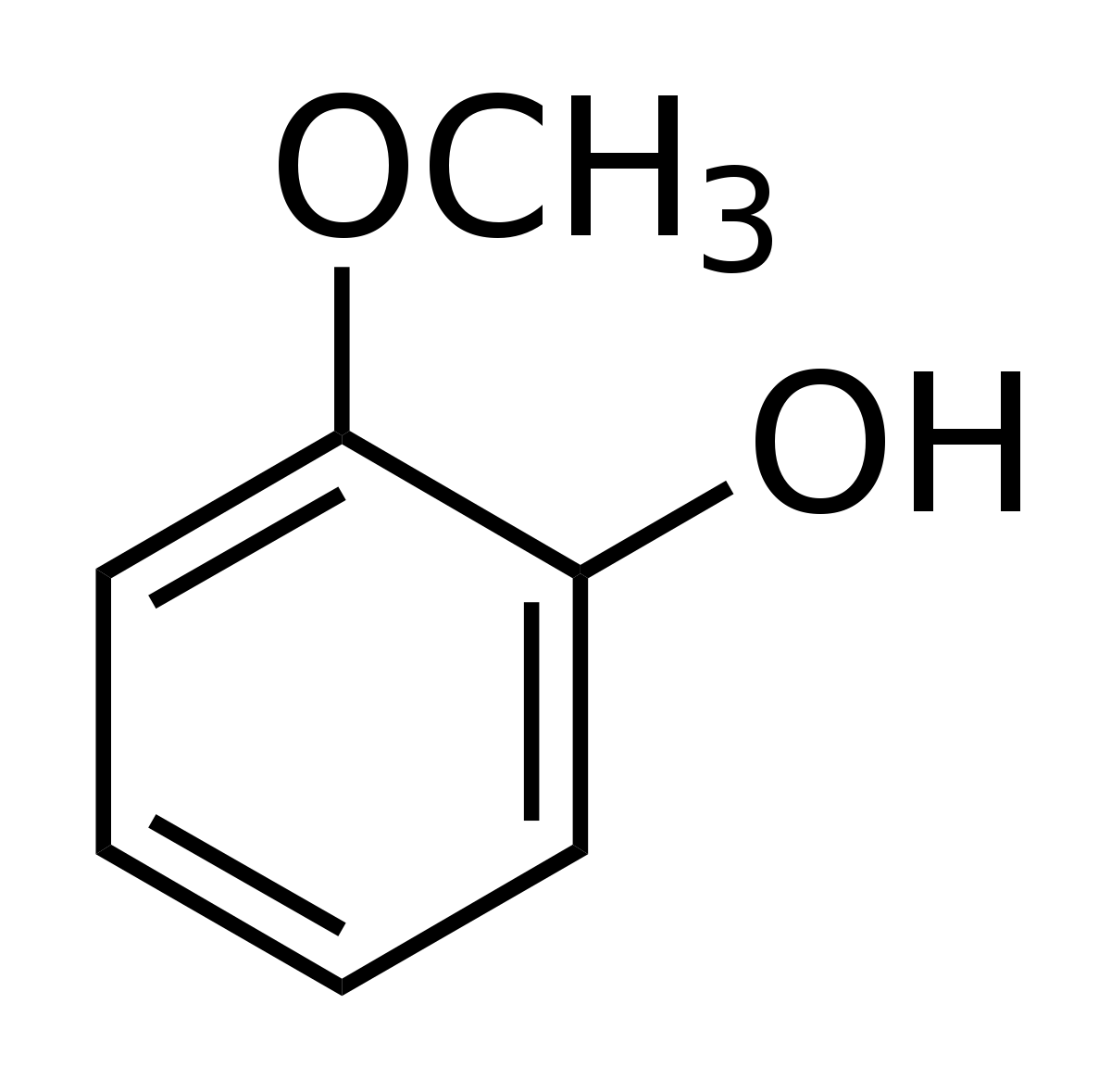

Según simulación informática, el whisky está mejor con agua añadida

Según dos científicos suecos, la mejor manera de disfrutar un whisky es agregar un poco de agua. La dilución liberaría una pequeña molécula aromática, el guaiacol, particularmente presente en los whiskies escoceses.

Según dos científicos suecos, la mejor manera de disfrutar un whisky es agregar un poco de agua. La dilución liberaría una pequeña molécula aromática, el guaiacol, particularmente presente en los whiskies escoceses.

La fabricación del whisky comienza con etapas de fermentación y destilación. El whisky, que contiene aproximadamente el 70 % de alcohol por volumen en esta etapa, se envejece con los años. El alcohol se evapora durante esta maduración, resultando en un nivel de alcohol de aproximadamente 55-65 %. Antes del embotellado, el whisky se diluye hasta aproximadamente el 40 % añadiendo agua, lo que altera su sabor. Pero algunos aficionados todavía afirman verter un poco de agua en su copa para probar y mejorar su sabor.

En un artículo en Scientific Reports, Bjorn Karlsson y Ran Friedman querían saber si la adición de agua en el whisky realmente le dio más sabor. Para ello, utilizaron una simulación por ordenador y modelaron la composición del whisky. Hay dos hipótesis para explicar que la adición de agua mejora las cualidades gustativas del whisky, como explicó Bjorn Karlsson en el Washington Post. La primera es que el agua atrapa compuestos desagradables: ésteres de ácidos grasos. Pero según los investigadores, estos ésteres están presentes en concentraciones demasiado bajas para desempeñar un papel.

Guaiacol en la superficie del whisky diluido

La segunda hipótesis es que el agua libera moléculas que mejoran el sabor. El agua y el alcohol no se mezclan bien, los compuestos aromáticos pueden quedar atrapados en etanol y no llegar a la superficie. El whisky contiene muchos compuestos, pero los investigadores se han concentrado en guaiacol (C7H8O2), una pequeña molécula hidrofóbica que da un sabor ahumado, y más común en whisky escocés que whisky americano o irlandés.

Basándose en estas simulaciones, la concentración de etanol tuvo un efecto sobre el guaiacol. A diluciones por debajo del 45 %, es decir, a concentraciones de embotellado, el etanol se acumula en la superficie con guaiacol, donde se puede consumir. Pero por encima del 59 % de etanol, la concentración después de la destilación y antes de la dilución, el guaiacol está más rodeado de moléculas de etanol y menos presente en la superficie, y por lo tanto, en los eflujos liberados

Ordenadores «inteligentes» para procesar EEG

Filtrar información para los motores de búsqueda, actuar como oponente en juegos o reconocer imágenes: La inteligencia artificial ha superado con mucho la inteligencia humana en ciertas tareas. Varios grupos del clúster de excelencia de Friburgo, BrainLinks-BrainTools, dirigidos por el profesor de neurociencias Dr. Tonio Ball, están demostrando cómo las ideas de la informática podrían revolucionar la investigación del cerebro. En la revista científica Human Brain Mapping, ilustran cómo un algoritmo de autoaprendizaje decodifica las señales del cerebro humano que fueron medidas por un electroencefalograma (EEG). Incluye movimientos realizados, pero también movimientos de manos y pies que eran meramente pensamientos o una rotación imaginaria de objetos. A pesar de que al algoritmo no se le dio ninguna característica previamente, funciona de forma tan rápida y precisa como los sistemas tradicionales que han sido creados para resolver ciertas tareas basadas en señales cerebrales predeterminadas, que por lo tanto no son apropiadas para cada situación. La demanda de intersecciones tan diversas entre el hombre y la máquina es enorme: en el Hospital Universitario de Friburgo, por ejemplo, podría utilizarse para la detección temprana de crisis epilépticas. También podría utilizarse para mejorar las posibilidades de comunicación para los pacientes gravemente paralizados o para un diagnóstico neurológico automático.

«Nuestro software se basa en modelos inspirados en el cerebro que han demostrado ser más útiles para descifrar diversas señales naturales como los sonidos fonéticos», dice el científico informático Robin Tibor Schirrmeister. El investigador lo está utilizando para reescribir los métodos que el equipo ha utilizado para decodificar datos de EEG: las denominadas redes neuronales artificiales son el corazón del proyecto actual en BrainLinks-BrainTools. «Lo destacado acerca del programa es que no es necesario predeterminar las características. La información es procesada capa por capa, es decir, en varios pasos con la ayuda de una función no lineal. El sistema aprende a reconocer y diferenciar entre ciertos patrones de comportamiento de varios movimientos a medida que suceden», explica Schirrmeister. El modelo se basa en las conexiones entre las células nerviosas en el cuerpo humano en el que las señales eléctricas de las sinapsis se dirigen desde las protuberancias celulares al núcleo de la célula y viceversa. «Las teorías han estado en circulación durante décadas, pero no fue sino hasta el surgimiento de la potencia de procesamiento de los ordenadores actuales que el modelo se ha hecho factible», comenta Schirrmeister.

Habitualmente, la precisión del modelo mejora con un gran número de capas de procesamiento. Hasta 31 se utilizaron durante el estudio, también conocido como «Aprendizaje Profundo». Hasta ahora, había sido problemático interpretar los circuitos de la red después de completar el proceso de aprendizaje. Todos los procesos algorítmicos tienen lugar en el fondo y son invisibles. Es por eso que los investigadores desarrollaron el software para crear tarjetas a partir de las cuales podían entender las decisiones de decodificación. Los investigadores pueden insertar nuevos conjuntos de datos en el sistema en cualquier momento. «A diferencia del método antiguo, ahora podemos ir directamente a las señales crudas que el EEG registra del cerebro, nuestro sistema es tan preciso, si no mejor, que el antiguo», dice el investigador jefe Tonio Ball, resumiendo el estudio de la investigación. El potencial de la tecnología aún no se ha agotado – junto con su equipo, el investigador desea continuar su desarrollo: «Nuestra visión para el futuro incluye algoritmos de autoaprendizaje que pueden confiable y rápidamente reconocer las diversas intenciones del usuario basadas en sus señales cerebrales Además, estos algoritmos podrían ayudar a los diagnósticos neurológicos «.

Ampliar en: https://arxiv.org/abs/1703.05051

Primera transmisión de datos a través de un multiplexor de terahercios

La multiplexación, capacidad de enviar múltiples señales a través de un solo canal, es una característica fundamental de cualquier sistema de comunicación de voz o datos. Un equipo de investigación internacional ha mostrado por primera vez un método para multiplexar datos transmitidos por ondas de terahercios, radiación de alta frecuencia que puede posibilitar una próxima generación de redes inalámbricas de ancho de banda ultra-alto.

En la revista Nature Communications, los investigadores informan de la transmisión de dos señales de vídeo en tiempo real a través de un multiplexor de terahercios a una velocidad de datos agregada de 50 gigabits por segundo, aproximadamente 100 veces la velocidad óptima de datos de la red móvil celular más rápida de las actuales.

«Demostramos que podemos transmitir flujos de datos separados en ondas terahercios a velocidades muy altas y con tasas de errores muy bajas», dijo Daniel Mittleman, profesor de la Escuela de Ingeniería de Brown y coautor del documento. «Esta es la primera vez que alguien ha caracterizado un sistema de multiplexación terahercios utilizando datos reales, y los resultados muestran que nuestro enfoque podría ser viable en futuras redes inalámbricas a frecuencias de terahercios».

Las redes actuales de voz y datos utilizan microondas para llevar señales inalámbricas. Pero la demanda de transmisión de datos se está convirtiendo rápidamente en algo más de lo que las redes de microondas pueden manejar. Las ondas de terahercio tienen frecuencias más altas que las microondas y por lo tanto una capacidad mucho mayor para transportar datos. Sin embargo, los científicos apenas han comenzado a experimentar con estas frecuencias, y muchos de los componentes básicos necesarios para la comunicación teraherciios todavía no existen.

Un sistema para multiplexar y demultiplexar (también conocido como mux/demux) es uno de esos componentes básicos. Es la tecnología que permite a un cable llevar múltiples canales de televisión o a cientos de usuarios acceder a una red wifi inalámbrica.

Enfoque mux/demux

Mittleman y sus colegas desarrollaron dos placas de metal colocadas paralelas entre sí para formar una guía de ondas. Una de las placas tiene un corte. Cuando las ondas viajan a través de la guía de ondas, parte de la radiación se escapa a través de la hendidura. El ángulo en el que los haces de radiación escapan depende de la frecuencia de la onda.

«Podemos poner varias ondas a varias frecuencias diferentes – cada una de las cuales lleva una corriente de datos – en la guía de ondas, y no interferirán entre sí porque son frecuencias diferentes, eso es multiplexar», dijo Mittleman. «Cada una de esas frecuencias se escapa de la hendidura en un ángulo diferente, separando los flujos de datos, eso es demultiplexar».

Debido a la naturaleza de las ondas de terahercios, las señales en estas redes de comunicaciones se propagarán como haces direccionales, no transmisiones omnidireccionales como en los sistemas inalámbricos existentes. Esta relación direccional entre el ángulo de propagación y la frecuencia es la clave para habilitar mux/demux en estos sistemas. Un usuario en una ubicación particular (y por lo tanto en un ángulo particular desde el sistema de multiplexación) se comunicará en una frecuencia particular.

En 2015, el laboratorio de Mittleman publicó por primera vez un artículo describiendo su concepto de guía de ondas. Para ese trabajo inicial, el equipo utilizó una fuente de luz terahercios de banda ancha para confirmar que diferentes frecuencias surgieron del dispositivo en diferentes ángulos. Si bien esa fue una prueba efectiva de concepto, Mittleman dijo, este último trabajo tomó el paso crítico de probar el dispositivo con datos reales.

Trabajando con Guillaume Ducournau en el Instituto de Electrónica, Microelectrónica y Nanotecnología, CNRS / Universidad de Lille, en Francia, los investigadores codificaron dos emisiones de televisión de alta definición en ondas terahertz de dos frecuencias diferentes: 264,7 GHz y 322,5 GHz. Entonces transmitieron ambas frecuencias juntas en el sistema multiplexor, con un receptor de televisión fijado para detectar las señales como emergieron del dispositivo. Cuando los investigadores alinearon su receptor al ángulo desde el cual se emitieron las ondas de 264,7 GHz, vieron el primer canal. Cuando se alinearon con 322,5 GHz, vieron el segundo.

Otros experimentos mostraron que las transmisiones estaban libres de errores hasta 10 gigabits por segundo, lo cual es mucho más rápido que las velocidades wifi estándar actuales. Las tasas de error aumentaron algo cuando la velocidad aumentó a 50 gigabits por segundo (25 gigabits por canal), pero todavía estaban dentro del rango que se puede ajustar mediante la corrección de errores, que se utiliza comúnmente en las redes de comunicaciones actuales.

Además de demostrar que el dispositivo funcionó, Mittleman dice que la investigación reveló algunos detalles sorprendentes sobre la transmisión de datos en las ondas a terahercios. Cuando una onda se modula para codificar datos – es decir, activado y desactivado para hacer ceros y unos – la onda principal está acompañada por frecuencias de banda lateral que también deben ser detectadas por un receptor para transmitir todos los datos. La investigación mostró que el ángulo del detector con respecto a las bandas laterales es importante para mantener la tasa de error baja.

«Si el ángulo está un poco desfasado, podríamos estar detectando toda la potencia de la señal, pero estamos recibiendo una banda lateral un poco mejor que la otra, lo que aumenta la tasa de error». Mittleman explicó. «Así que es importante tener el ángulo correcto.»

Detalles fundamentales como ese serán críticos, dijo Mittleman, cuando llegue el momento de comenzar a diseñar la arquitectura para sistemas completos. «Es algo que no esperábamos, y muestra lo importante que es caracterizar estos sistemas usando datos en lugar de una fuente de radiación no modulada».

Los investigadores planean continuar desarrollando este y otros componentes. Recientemente recibió una licencia de la FCC para realizar pruebas al aire libre en frecuencias de terahercios en el campus de la Universidad Brown «Creemos que tenemos la licencia de mayor frecuencia emitida actualmente por la FCC, y esperamos que sea una señal de que la agencia esté empezando a pensar. Las compañías van a ser renuentes a desarrollar tecnologías de terahercios hasta que haya un serio esfuerzo de los reguladores para asignar las bandas de equencia para usos específicos, por lo que este es un paso en la dirección correcta.»

Ampliar en: EurekaAlert¡

autobus las palmas aeropuerto cetona de frambuesa