Física

Física

Hay un dicho que indica que los datos se expandirán hasta llenar toda la capacidad disponible. Tal vez hace diez o veinte años, era común almacenar programas de software, música MP3, películas y otros archivos, que podáin haber sido recopilados durante años. En los días en que las unidades de disco duro ofrecían unas pocas decenas de gigabytes de almacenamiento, la falta de espacio era casi inevitable.

Ahora que tenemos internet de banda ancha rápida y no pensamos en la descarga de un DVD de 4,7 gigabytes, podemos acumular datos aún más rápidamente. Las estimaciones de la cantidad total de datos almacenados en todo el mundo aumentarán de 4,4 billones de gigabytes en 2013 a 44 billones de gigabytes en 2020. Esto significa que estamos generando un promedio de 15 millones de gigabytes al día. A pesar de que las unidades de disco duro ahora se miden en miles de gigabytes en lugar de decenas, todavía tenemos un problema de almacenamiento.

La investigación y el desarrollo se centran en el desarrollo de nuevos medios de almacenamiento de datos que son más densos y por lo que puede almacenar una mayor cantidad de datos, y hacerlo de una manera más eficiente de la energía. A veces esto implica actualizar técnicas establecidas: recientemente IBM anunció una nueva tecnología de cinta magnética que puede almacenar 25 gigabytes por pulgada cuadrada (una pulgada equivale a 2,54 cm), un nuevo récord mundial para la tecnología de 60 años de edad. Mientras que los actuales discos duros magnéticos o de estado sólido son más densos alrededor de 200 gigabytes por pulgada cuadrada, las cintas magnéticas todavía se utilizan con frecuencia para la copia de seguridad de datos.

Sin embargo, la vanguardia de la investigación de almacenamiento de datos está trabajando a nivel de átomos y moléculas individuales, representando el límite máximo de la miniaturización tecnológica.

Búsqueda de los imanes atómicos

Las tecnologías actuales de almacenamiento de datos magnéticos -las utilizadas en los discos duros tradicionales con platos giratorios, estándar hasta hace unos años y que todavía son comunes hoy en día- se basan en métodos «top-down». Esto implica hacer capas delgadas de una gran pieza de material ferromagnético, cada uno conteniendo muchos dominios magnéticos que se utilizan para contener datos. Cada uno de estos dominios magnéticos está hecho de una gran colección de átomos magnetizados, cuya polaridad magnética es establecida por la cabeza de lectura / escritura del disco duro para representar datos como binarios uno o cero.

Un método «ascendente» alternativo implicaría construir dispositivos de almacenamiento colocando átomos o moléculas individuales uno por uno, cada uno capaz de almacenar un solo bit de información. Los dominios magnéticos conservan su memoria magnética debido a la comunicación entre grupos de átomos magnetizados vecinos.

Los imanes de un solo átomo o de una sola molécula por otro lado no requieren esta comunicación con sus vecinos para retener su memoria magnética. En cambio, el efecto de memoria surge de la mecánica cuántica. Por lo tanto, debido a que los átomos o las moléculas son mucho, mucho más pequeños que los dominios magnéticos actualmente utilizados, y pueden usarse individualmente en lugar de en grupos, pueden ser empacados más estrechamente, lo que podría dar lugar a un enorme aumento en la densidad de datos.

Trabajar con átomos y moléculas como éste no es ciencia ficción. Los efectos de la memoria magnética en imanes de una sola molécula (SMMs) se demostró por primera vez en 1993, y efectos similares para los imanes de átomo único se mostraron en 2016.

Aumentar la temperatura

El problema principal que está en el camino de mover estas tecnologías fuera del laboratorio y en la corriente principal es que todavía no trabajan a temperaturas ambiente. Tanto los átomos individuales como los SMM requieren enfriamiento con helio líquido (a una temperatura de -269 ° C), un recurso costoso y limitado. Así, el esfuerzo de investigación durante los últimos 25 años se ha concentrado en elevar la temperatura a la que se puede observar la histéresis magnética, una demostración del efecto de la memoria magnética. Un objetivo importante es -196 ° C, porque esta es la temperatura que se puede lograr con el nitrógeno líquido, que es abundante y barato.

Tomó 18 años para el primer paso sustancial para elevar la temperatura en la que la memoria magnética es posible en SMMs – un aumento de 10 ° C logrado por los investigadores en California. Pero ahora el equipo de investigación en la Escuela de Química de la Universidad de Manchester ha logrado histéresis magnéticas en un SMM a -213 ° C usando una nueva molécula basada en el elemento de tierras raras disprosio, según se informa en una carta a la revista Nature. Con un salto de 56 ° C, esto está a sólo 17 ° C de la temperatura del nitrógeno líquido.

Usos futuros

Sin embargo, hay otros desafíos. Con el fin de almacenar prácticamente bits individuales de datos, las moléculas deben fijarse a las superficies. Esto se ha demostrado con SMMs en el pasado, pero no para esta última generación de SMMs de alta temperatura. Por otra parte, la memoria magnética en átomos individuales ya se ha demostrado en una superficie.

La prueba definitiva es la demostración de la escritura y la lectura no destructiva de datos en átomos o moléculas individuales. Esto ha sido logrado por primera vez en 2017 por un grupo de investigadores de IBM que demostró el dispositivo de almacenamiento de memoria magnética más pequeño del mundo, construido alrededor de un solo átomo.

Sin embargo, independientemente de si los dispositivos de almacenamiento de un solo átomo o de una sola molécula se vuelven verdaderamente prácticos, los avances en la ciencia fundamental que se están realizando a lo largo de este camino son fenomenales. Las técnicas de química sintética desarrolladas por los grupos que trabajan en SMM ahora nos permiten diseñar moléculas con propiedades magnéticas personalizadas, que tendrán aplicaciones en la computación cuántica e incluso la resonancia magnética.

Ampliar en: The Conversation

La multiplexación, capacidad de enviar múltiples señales a través de un solo canal, es una característica fundamental de cualquier sistema de comunicación de voz o datos. Un equipo de investigación internacional ha mostrado por primera vez un método para multiplexar datos transmitidos por ondas de terahercios, radiación de alta frecuencia que puede posibilitar una próxima generación de redes inalámbricas de ancho de banda ultra-alto.

En la revista Nature Communications, los investigadores informan de la transmisión de dos señales de vídeo en tiempo real a través de un multiplexor de terahercios a una velocidad de datos agregada de 50 gigabits por segundo, aproximadamente 100 veces la velocidad óptima de datos de la red móvil celular más rápida de las actuales.

«Demostramos que podemos transmitir flujos de datos separados en ondas terahercios a velocidades muy altas y con tasas de errores muy bajas», dijo Daniel Mittleman, profesor de la Escuela de Ingeniería de Brown y coautor del documento. «Esta es la primera vez que alguien ha caracterizado un sistema de multiplexación terahercios utilizando datos reales, y los resultados muestran que nuestro enfoque podría ser viable en futuras redes inalámbricas a frecuencias de terahercios».

Las redes actuales de voz y datos utilizan microondas para llevar señales inalámbricas. Pero la demanda de transmisión de datos se está convirtiendo rápidamente en algo más de lo que las redes de microondas pueden manejar. Las ondas de terahercio tienen frecuencias más altas que las microondas y por lo tanto una capacidad mucho mayor para transportar datos. Sin embargo, los científicos apenas han comenzado a experimentar con estas frecuencias, y muchos de los componentes básicos necesarios para la comunicación teraherciios todavía no existen.

Un sistema para multiplexar y demultiplexar (también conocido como mux/demux) es uno de esos componentes básicos. Es la tecnología que permite a un cable llevar múltiples canales de televisión o a cientos de usuarios acceder a una red wifi inalámbrica.

Enfoque mux/demux

Mittleman y sus colegas desarrollaron dos placas de metal colocadas paralelas entre sí para formar una guía de ondas. Una de las placas tiene un corte. Cuando las ondas viajan a través de la guía de ondas, parte de la radiación se escapa a través de la hendidura. El ángulo en el que los haces de radiación escapan depende de la frecuencia de la onda.

«Podemos poner varias ondas a varias frecuencias diferentes – cada una de las cuales lleva una corriente de datos – en la guía de ondas, y no interferirán entre sí porque son frecuencias diferentes, eso es multiplexar», dijo Mittleman. «Cada una de esas frecuencias se escapa de la hendidura en un ángulo diferente, separando los flujos de datos, eso es demultiplexar».

Debido a la naturaleza de las ondas de terahercios, las señales en estas redes de comunicaciones se propagarán como haces direccionales, no transmisiones omnidireccionales como en los sistemas inalámbricos existentes. Esta relación direccional entre el ángulo de propagación y la frecuencia es la clave para habilitar mux/demux en estos sistemas. Un usuario en una ubicación particular (y por lo tanto en un ángulo particular desde el sistema de multiplexación) se comunicará en una frecuencia particular.

En 2015, el laboratorio de Mittleman publicó por primera vez un artículo describiendo su concepto de guía de ondas. Para ese trabajo inicial, el equipo utilizó una fuente de luz terahercios de banda ancha para confirmar que diferentes frecuencias surgieron del dispositivo en diferentes ángulos. Si bien esa fue una prueba efectiva de concepto, Mittleman dijo, este último trabajo tomó el paso crítico de probar el dispositivo con datos reales.

Trabajando con Guillaume Ducournau en el Instituto de Electrónica, Microelectrónica y Nanotecnología, CNRS / Universidad de Lille, en Francia, los investigadores codificaron dos emisiones de televisión de alta definición en ondas terahertz de dos frecuencias diferentes: 264,7 GHz y 322,5 GHz. Entonces transmitieron ambas frecuencias juntas en el sistema multiplexor, con un receptor de televisión fijado para detectar las señales como emergieron del dispositivo. Cuando los investigadores alinearon su receptor al ángulo desde el cual se emitieron las ondas de 264,7 GHz, vieron el primer canal. Cuando se alinearon con 322,5 GHz, vieron el segundo.

Otros experimentos mostraron que las transmisiones estaban libres de errores hasta 10 gigabits por segundo, lo cual es mucho más rápido que las velocidades wifi estándar actuales. Las tasas de error aumentaron algo cuando la velocidad aumentó a 50 gigabits por segundo (25 gigabits por canal), pero todavía estaban dentro del rango que se puede ajustar mediante la corrección de errores, que se utiliza comúnmente en las redes de comunicaciones actuales.

Además de demostrar que el dispositivo funcionó, Mittleman dice que la investigación reveló algunos detalles sorprendentes sobre la transmisión de datos en las ondas a terahercios. Cuando una onda se modula para codificar datos – es decir, activado y desactivado para hacer ceros y unos – la onda principal está acompañada por frecuencias de banda lateral que también deben ser detectadas por un receptor para transmitir todos los datos. La investigación mostró que el ángulo del detector con respecto a las bandas laterales es importante para mantener la tasa de error baja.

«Si el ángulo está un poco desfasado, podríamos estar detectando toda la potencia de la señal, pero estamos recibiendo una banda lateral un poco mejor que la otra, lo que aumenta la tasa de error». Mittleman explicó. «Así que es importante tener el ángulo correcto.»

Detalles fundamentales como ese serán críticos, dijo Mittleman, cuando llegue el momento de comenzar a diseñar la arquitectura para sistemas completos. «Es algo que no esperábamos, y muestra lo importante que es caracterizar estos sistemas usando datos en lugar de una fuente de radiación no modulada».

Los investigadores planean continuar desarrollando este y otros componentes. Recientemente recibió una licencia de la FCC para realizar pruebas al aire libre en frecuencias de terahercios en el campus de la Universidad Brown «Creemos que tenemos la licencia de mayor frecuencia emitida actualmente por la FCC, y esperamos que sea una señal de que la agencia esté empezando a pensar. Las compañías van a ser renuentes a desarrollar tecnologías de terahercios hasta que haya un serio esfuerzo de los reguladores para asignar las bandas de equencia para usos específicos, por lo que este es un paso en la dirección correcta.»

Ampliar en: EurekaAlert¡

Casi todo lo que es genial sobre la tecnología de hoy es gracias al microprocesador. Miles de millones de ellos se fabrican cada año y son una de las muchas razones por las que puede leer esta web. Pero pocas personas entienden lo que está pasando dentro de ese pequeño circuito integrado. Vamos con un curso acelerado.

La gente del Centro de Informática de Cambridge tiene una máquina de media tonelada que muestra todos los pequeños detalles que ocurren en un microprocesador a un tamaño que es más fácil de inspeccionar. La máquina ha sido apodada The Megaprocessor y su creador, James Newman, nos guía a través de cómo funciona en el vídeo de abajo.

La creación de Newman es lo suficientemente vistosa como para admirarla por sí sola. Usando unos 40000 transistores y 10000 LEDs, la máquina diagrama todas las comunicaciones y sistemas numéricos que se están llevando a cabo dentro de un microprocesador, todo ello y como vemos, con el fin de jugar en última instancia a una partida de Tetris.

Los dueños del vehículo se encontraban en un pequeño mercado local. Y mientras preparaban un escritorio que habían comprado para su hija, el hombre había dejado su nuevo Samsung Note 7 cargando dentro del coche Jeep. Cuando iban a volver su perro los estaba alertando, pero ya era demasiado tarde: el auto estaba en llamas.

Según informaron en las noticias de la FOX 13 , un representante de Samsung estaría al tanto de la situación y haría “todo lo posible” por la familia.

Fuente: conéctica

Durante décadas, la ciencia ha tratado de recrear la estructura del cerebro humano, pero hasta ahora era imposible imitar su potencia y densidad con los componentes disponibles. IBM acaba de dar un paso interesante hacia el cerebro positrónico imaginado por Asimov. Ha creado neuronas artificiales funcionales mediante tecnología de cambio de fase.

No es la primera vez que IBM anuncia un avance en esta tecnología de almacenamiento no volátil (los datos no desaparecen al apagar el dispositivo) basada en cristales que alteran su estructura molecular al recibir corriente eléctrica de diferente intensidad. Recientemente la compañía logró crear memoria de cambio de fase a un coste similar al de la RAM actual.

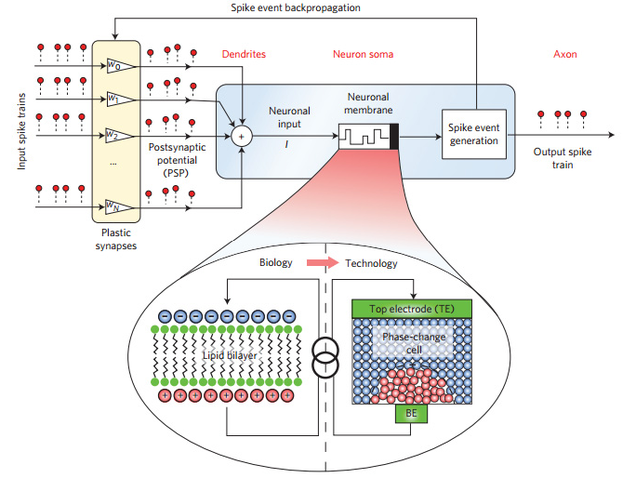

Esquema de las neuronas artificiales de cambio de fase. Foto: IBM

Sin embargo, este nuevo avance de IBM va mucho más allá de lograr que nuestro PC funcione con más agilidad. Lo que el equipo de investigadores que la compañía mantiene en Zurich ha logrado crear son neuronas que imitan perfectamente el funcionamiento de las neuronas humanas. En lugar de una membrana con enzimas, las neuronas artificiales unen el axon y las dendritas mediante un cristal de antimonio, germanio y telurio, un material similar al que se utiliza en los discos ópticos reescribibles.

Estas neuronas de cristal que cambia su estado se parecen mucho a su contrapartida biológica. Para empezar, su tamaño puede reducirse a unos pocos nanómetros, lo que permite agrupar la suficiente cantidad de estas neuronas en un espacio lo bastante reducido.

En la primera prueba, IBM ha puesto a funcionar 500 de estas neuronas en una hilera de cinco chips compuestos de 10×10 de estas neuronas, pero el sistema es escalable. Los investigadores explican en el estudio que han publicdo en Nature que se podrían crear chips viables para comercialización de 90 nanómetros ya mismo, y que en el futuro se podría reducir hasta 14 nanómetros.

… …

Artículo completo en: GIZMODO

Científicos de la Universidad de Maryland han logrado crear el primer ordenador cuántico programable, una característica que no se había conseguido hasta la fecha. El dispositivo, que emplea cinco bits cuánticos o qubits, podría ser escalado hasta alcanzar dimensiones más grandes, según explican los investigadores en un trabajo publicado en Nature, aunque esta posibilidad no ha sido demostrada todavía.

Científicos de la Universidad de Maryland han logrado crear el primer ordenador cuántico programable, una característica que no se había conseguido hasta la fecha. El dispositivo, que emplea cinco bits cuánticos o qubits, podría ser escalado hasta alcanzar dimensiones más grandes, según explican los investigadores en un trabajo publicado en Nature, aunque esta posibilidad no ha sido demostrada todavía.

El equipo desarrollado por Shantanu Debnath se basa en una de las arquitecturas cuánticas más antiguas, que fue ideada en 1995 gracias a los trabajos del físico español Juan Ignacio Cirac y el austriaco Peter Zoller. Los bits cuánticos se almacenan en iones atómicos individuales que se encuentran «atrapados» en línea gracias al uso de campos magnéticos y potentes láseres. Los iones se comportan como un pequeño cristal, de manera que se pueden controlar las vibraciones de forma precisa y así provocar que los iones queden entrelazados.

Este entrelazamiento permite el funcionamiento del ordenador cuántico, un dispositivo que, en palabras de Cirac: «resuelve los mismos problemas que los ordenadores usuales, lo que pasa que mucho más rápido». En lugar de utilizar las reglas de los computadores habituales, como ceros y unos, puertas lógicas o combinación de puertas lógicas, funcionan con las normas de la física cuántica. Esto les permite trabajar a mayor velocidad y, sobre todo, resolver problemas con una gran eficiencia. El reto, según explicó Cirac a Hipertextual, es que no existe todavía un ordenador cuántico real, sino que sólo contamos con pequeños prototipos.

Noticia completa en: Ordenador cuántico

Si se desea mantener información oculta, es probable pensar en cifrarla. Lo hacemos todo el tiempo para cosas como las transacciones con tarjetas de crédito, los datos en el teléfono, y hasta muchos sitios web. El cifrado es una manera de asegurar que solo el destinatario deseado puede tener acceso a su información. Es decir, a menos que alguien sea capaz de descifrar el código.

Uno de los métodos más comunes de cifrado se conoce como cifrado de clave pública, donde se introduce un número aleatorio de gran tamaño en un algoritmo generador de claves para crear un par de claves pública y privada. La clave pública se puede utilizar para cifrar un mensaje que sólo puede ser descifrado con la clave privada. Siempre y cuando la clave privada se mantenga como privada, esto funciona bastante bien. Una pega es que se necesita un número aleatorio grande, y lo ideal es que tiene que ser verdaderamente al azar. Si alguien pudiera predecir el número al azar, se podría generar la misma clave pública y privada.

Pero a menudo los números «aleatorios» sólo son pseudo-aleatorios. Parecen números aleatorios, por el uso de un algoritmo especial para simular la aleatoriedad. Para obtener mejores números aleatorios, se pueden utilizar las fluctuaciones térmicas en el ordenador, o ruido de los datos meteorológicos. O como en el caso indicado en un nuevo artículo científico, los datos del fondo cósmico de microondas. Podría parecer que el CMB es una muy mala elección. Después de todo, puede ser visto por todo el mundo, así que si se usan los datos de CMB para crear un número aleatorio, por qué no puede alguien obtener el mismo número? Pero resulta que eso no es un problema.

La idea básica es tomar un pedazo de cielo y medir la distribución de la energía del CMB, específicamente lo que se conoce como el espectro de potencia. Ese espectro es a continuación, comparado con el ideal teórico, y la diferencia crea un número aleatorio. Incluso si alguien mide exactamente el mismo trozo de cielo, no obtiene el mismo resultado exacto, por lo que no obtendría el mismo número. Mientras que los autores utilizan el CMB como ejemplo, señalan un método similar podría utilizarse para generar números aleatorios desde la línea de 21 centímetros, remanentes de supernovas, galaxias de radio y otros fenómenos astrofísicos. Todo lo que necesitas es un radiotelescopio básico, y se tiene un generador de números aleatorios.

No es probable que este método astrofísico sea mejor que los usados ahora. Variaciones térmicas y los patrones climáticos son bastante aleatorioss. Pero es una idea interesante utilizar los secretos del universo para mantener sus propios secretos.

Fuente: Jeffrey S. Lee and Gerald B. Cleaver. The Cosmic Microwave Background Radiation Power Spectrum as a Random Bit Generator for Symmetric and Asymmetric-Key Cryptography. arXiv:1511.02511 [cs.CR] (2015)