Actualidad informática

Noticias y novedades sobre informática

Block-chain en la cadena de suministros alimentarios

IBM anunció hoy que está trabajando con un consorcio que incluye Dole, Golden State Foods, Kroger, McCormick y Company, Nestlé, Tyson Foods, Unilever y Walmart para llevar el beneficio de las cadenas de bloques (block-chains) a la cadena de suministro de alimentos.

IBM anunció hoy que está trabajando con un consorcio que incluye Dole, Golden State Foods, Kroger, McCormick y Company, Nestlé, Tyson Foods, Unilever y Walmart para llevar el beneficio de las cadenas de bloques (block-chains) a la cadena de suministro de alimentos.

IBM, al igual que la mayoría de sus competidores en el espacio de computación en la nube pública, ha estado trabajando en varios proyectos de cadenas de bloques en los últimos meses.

Dada la complejidad de la cadena de suministro de alimentos de productor a consumidor, block-chains podría encontrar un nicho muy interesante aquí porque permitiría más transparencia y trazabilidad (especialmente cuando las cosas van mal). La idea detrás de este proyecto y la colaboración entre estas diferentes empresas es averiguar dónde exactamente puede beneficiar el ecosistema de alimentos.

«La tecnología de Blockchain permite una nueva era de transparencia de extremo a extremo en el sistema alimentario mundial», escribe Frank Yiannas, vicepresidente de seguridad alimentaria de Walmart. «También permite a todos los participantes compartir información rápidamente y con confianza a través de una sólida red de confianza».

No es de sorprender que la Plataforma Blockchain de IBM constituya la base de gran parte de este trabajo. Soporta las tecnologías Hyperledger Fabric y Hyperledger Composer de Linux Foundation para la creación de aplicaciones basadas en cadenas de bloques.

Es interesante ver cómo una serie de grandes jugadores están trabajando para llevar block-chains a las empresas. A principios de este mes, por ejemplo, Microsoft lanzó un nuevo proyecto para hacer block-chains listos para la empresa, también, por ejemplo. A principios de este año, un estudio de IBM también encontró que un tercio de las empresas están buscando en cómo esta tecnología puede beneficiar a su negocio.

El manifiesto de Google no es sexista o anti-diversidad. Es ciencia

En estos días se ha oído hablar del llamado manifiesto de «anti-diversidad» de Google y cómo James Damore, el ingeniero que lo escribió, ha sido despedido de su trabajo.

Damore dijo que la brecha de género en la diversidad de Google no se debía a la discriminación, sino a diferencias inherentes en lo que los hombres y las mujeres consideran interesante. Danielle Brown, nueva vicepresidenta de Google para la diversidad, integridad y gobernabilidad, acusó al manifiesto de avanzar «suposiciones incorrectas sobre género», y Damore confirmó anoche que fue despedido por «perpetuar los estereotipos de género».

A pesar de cómo se ha valorado, el memorándum era justo y factualmente exacto. Los estudios científicos han confirmado las diferencias sexuales en el cerebro que conducen a diferencias en nuestros intereses y comportamiento.

Como se menciona en el memorándum, los intereses de género se predicen por la exposición a la testosterona prenatal – niveles más altos se asocian con una preferencia por las cosas mecánicamente interesantes y las ocupaciones en la edad adulta. Los niveles más bajos se asocian con una preferencia por las actividades y ocupaciones orientadas a las personas.Esta es la razón por la cual los campos STEM (ciencia, tecnología, ingeniería y matemáticas) tienden a ser mayoritariamente ocupados por los hombres.

Se ven pruebas de esto en las niñas con una condición genética llamada hiperplasia suprarrenal congénita, que están expuestas a niveles inusualmente altos de testosterona en el útero. Cuando nacen, estas niñas prefieren los juguetes con ruedas, como los camiones, incluso si sus padres ofrecen más retroalimentación positiva cuando juegan con juguetes típicos femeninos, como muñecas. Del mismo modo, los hombres que están interesados en las actividades típicas de la mujer, probablemente estuvieron expuestos a niveles más bajos de testosterona.

Además, nuevas investigaciones en el campo de la genética demuestran que la testosterona altera la programación de células madre neurales, lo que lleva a las diferencias sexuales en el cerebro, incluso antes de que termine de desarrollarse en el útero. Esto sugiere además que nuestros intereses están fuertemente influenciados por la biología, en oposición a ser aprendidos o socialmente construidos.

Muchas personas, entre ellas el ex empleado de Google, han intentado refutar los puntos del memorandum, alegando que contradicen las últimas investigaciones.

Me encantaría saber qué «investigación hecha […] durante décadas» se refiere, porque miles de estudios sugieren lo contrario. Un solo estudio, publicado en 2015, afirmó que los cerebros masculinos y femeninos existían a lo largo de un «mosaico» y que no es posible diferenciarlos por sexo, pero esto ha sido refutado por cuatro – sí, cuatro – estudios académicos desde entonces.

Esto incluye un estudio que analizó exactamente los mismos datos del cerebro del estudio original y encontró que el sexo de un cerebro determinado podría ser correctamente identificado con un 69 a 77 por ciento de precisión.

Por supuesto, las diferencias existen a nivel individual, y esto no significa que el medio ambiente no juega ningún papel en nuestra formación. Pero afirmar que no hay diferencias entre los sexos cuando se miran los promedios grupales, o que la cultura tiene mayor influencia que la biología, simplemente no es cierto.

De hecho, la investigación ha demostrado que las culturas con mayor equidad de género tienen mayores diferencias sexuales en lo que respecta a las preferencias de trabajo, porque en estas sociedades, las personas son libres de elegir sus ocupaciones en función de lo que disfrutan.

Como sugiere el memorandum, no es realista tratar de cumplir una cuota de 50 por ciento de mujeres en STEM. A medida que la equidad de género continúa mejorando en las sociedades en desarrollo, debemos esperar que esta brecha de género se amplíe.

Esta tendencia continúa en el área de la personalidad, también. Contrariamente a lo que los detractores le harían creer, las mujeres tienen, en promedio, un nivel más alto en neuroticismo y ser agradables, y menor tolerancia al estrés.

Algunos intencionalmente niegan la ciencia porque temen que se utilice para justificar el mantenimiento de las mujeres de STEM. Pero el sexismo no es el resultado de conocer hechos. Es el resultado de lo que la gente elige hacer con ellos. Esto es exactamente lo que la muchedumbre de indignación debe movilizarse para, en lugar de negar la realidad biológica y estar contento de pasar un fin de semana doxxing un hombre para que él perdería su trabajo. En este punto, como se anunció en el manifiesto de Damore, deberíamos estar más preocupados por la diversidad de puntos de vista que la diversidad que gira alrededor del género.

Ampliar en: The Globe and Mail

Heinz Nixdorf

Heinz Nixdorf nació en la ciudad westfaliana de Paderborn , Alemania, siendo el hijo mayor de cinco hermanos, de Walter Nixdorf, vendedor ambulante y más tarde empleado de los ferrocarriles alemanes, y su esposa Anne. Fue a una escuela de la junta católica donde mostró por primera vez su talento para las matemáticas y la ciencia. La infancia y la juventud de Heinz Nixdorf fueron gastadas en circunstancias empobrecidas. Debido al desempleo de su padre en los años veinte y treinta durante la depresión mundial, su infancia fue moldeada por la pobreza. Sin embargo, Nixdorf consiguió una beca en un establecimiento de formación de maestros en Vallendar / Rhein cuando terminó su educación primaria. Pero la profesión de profesor no le convenía, ya que se sentía demasiado limitado en sus intereses y habilidades. No podía convencer ni a su madre ni a sus maestros. Así, escribió una carta al Ministerio de Educación de Berlín. En 1941 le permitieron visitar el Reismann-Gymnasium en Paderborn. En 1942, Nixdorf fue reclutado por la Wehrmacht y sirvió en el Frente Oriental. Desde que su padre murió en 1944, el joven Nixdorf, como hijo mayor, tuvo que asumir la responsabilidad de su familia después del final de la guerra en 1945 al asumir el trabajo estacional en una granja. En 1947 finalmente pudo terminar su educación después de hacer su Abitur (examen de ingreso a la universidad) en el Reisman Gymnasium de Paderborn.

Heinz Nixdorf nació en la ciudad westfaliana de Paderborn , Alemania, siendo el hijo mayor de cinco hermanos, de Walter Nixdorf, vendedor ambulante y más tarde empleado de los ferrocarriles alemanes, y su esposa Anne. Fue a una escuela de la junta católica donde mostró por primera vez su talento para las matemáticas y la ciencia. La infancia y la juventud de Heinz Nixdorf fueron gastadas en circunstancias empobrecidas. Debido al desempleo de su padre en los años veinte y treinta durante la depresión mundial, su infancia fue moldeada por la pobreza. Sin embargo, Nixdorf consiguió una beca en un establecimiento de formación de maestros en Vallendar / Rhein cuando terminó su educación primaria. Pero la profesión de profesor no le convenía, ya que se sentía demasiado limitado en sus intereses y habilidades. No podía convencer ni a su madre ni a sus maestros. Así, escribió una carta al Ministerio de Educación de Berlín. En 1941 le permitieron visitar el Reismann-Gymnasium en Paderborn. En 1942, Nixdorf fue reclutado por la Wehrmacht y sirvió en el Frente Oriental. Desde que su padre murió en 1944, el joven Nixdorf, como hijo mayor, tuvo que asumir la responsabilidad de su familia después del final de la guerra en 1945 al asumir el trabajo estacional en una granja. En 1947 finalmente pudo terminar su educación después de hacer su Abitur (examen de ingreso a la universidad) en el Reisman Gymnasium de Paderborn.

Con la ayuda de una beca Nixdorf pudo estudiar física en la Johann-Wolfgang-von-Goethe Universität en Fráncfort del Meno en 1947. Allí también tuvo seminarios en economía empresarial. En 1951 Nixdorf obtuvo un trabajo como estudiante aprendiz en el departamento de desarrollo de Remington Rand Corp. , donde aprendió los conocimientos básicos de las calculadoras de luz. Allí también se reunió con el físico y experto en procesamiento de datos Walter Sprick y se convirtió en su asistente. Cuando Sprick dejó la compañía para trabajar en IBM, le dio a Nixdorf sus inventos. Sprick fue referido por IBM como el padre de los lectores de texto automáticos y obtuvo dos patentes importantes. Con eso, Nixdorf desarrolló el Elektronensaldierer y el Elektronenmultiplizierer.

Nixdorf finalmente encontró un interés por sus máquinas en la central eléctrica Rheinisch-Westfalsche (RWE), en Essen, el mayor proveedor de energía en Alemania. La compañía concedió a Nixdorf una subvención de 30000 DM para el desarrollo de calculadoras basadas en tubos de vacío. Nixdorf también construyó las máquinas de calcuular que podrían ser conectadas a las máquinas de tarjetas perforadoras. En 1952, Nixdorf tomó la decisión de abandonar sus estudios y fundó el Labor für Impulstechnik en Essen. Contrató a su primer empleado Alfred Wierzioch y ambos estaban convencidos por la idea de la calculadora. En 1954 se publicó la primera computadora de tubo de vacío, llamada ES, y la LFI se amplió a diez técnicos.La joven empresa evolucionó muy rápido.

La compañía de Nixdorf se vio obligada a trasladarse a otra oficina, porque necesitaban más espacio. Inventaron muchos productos como el Wanderer Conti, la primera calculadora de escritorio del mundo con una impresora y el Nixdorf-Universal 820. La rápida expansión fue la razón por la que la empresa alquiló habitaciones en Paderborn, la ciudad natal de Nixdorf. Allí tenía más espacio para hacer su compañía más grande. En 1961 comenzó a construir su empresa con 60 empleados. En 1965 Nixdorf introdujo una calculadora de escritorio en Hannover Messe . Técnicamente fue una revolución. La empresa Nixdorf inventó el sistema Nixdorf 820 en 1967, que tuvo mucho éxito. El sistema 820 que se construyó sobre una base de componentes fue el primer ordenador pequeño que se basó en semiconductores. El mismo año, Nixdorf tuvo la idea de no sólo vender a través de distribuidores más, sino vender los productos por sí mismo. En 1968 Nixdorf compró el Wanderer-Werke y renombró la compañía en Nixdorf Computer AG.

Los productores como IBM eran de confianza en mainframes, pero Heinz Nixdorf reconoció que los mainframes eran demasiado caros para muchas preocupaciones, por lo que presentó su Nixdorf 820. Con eso trajo la computadora directamente a la oficina y la gente podía permitírselo. El tiempo más exitoso para la Nixdorf Computer AG se inició en la década de 1970, cuando Nixdorf Computer AG se convirtió en el líder del mercado de la informática de gama media en Alemania y fue la cuarta empresa informática en Europa con lugares en Alemania, Irlanda, Estados Unidos y Singapur. En 1972, estaba representada en 22 países. En 1975, la Heinz Nixdorf Company produjo una nueva generación de captura de datos: la línea 88xx.

El 17 de marzo de 1986, Nixdorf murió de un ataque al corazón en Hannover en la primera feria de informática de CeBIT. Nixdorf estaba muy interesado en la educación de sus empleados, por lo que puso mucho esfuerzo personal y dinero en ella. Debido a eso, 1969 él fundó una escuela de comercio en las premisas de la compañía. También quería que sus empleados hicieran deporte. Las lecciones deportivas eran obligatorias y para una mejor oportunidad de hacer deporte, estableció el Ahorn-Sportpark en 1984.

Ampliar en: SciHi Blog

Ordenador cuántico de Google

«Deberíamos tener listo un chip de 20 qubit muy pronto … en los próximos dos meses lo más probable», dice John Martinis de Google, mientras nos apoyamos contra una pared en un rincón relativamente tranquilo del centro de convenciones en Nueva Orleans. Martinis, un hombre alto con pelo plateado y una manera Alan Alda-es que, está muy ocupado y tengo suerte de haberlo atrapado. Anteriormente ese día, dio una de las discusiones más populares de la APS March Meeting 2017 sobre «la supremacía cuántica: comparar una computadora cuántica con un supercomputador clásico«. Martinis, cuyo equipo está basado en la UC Santa Bárbara, habló sobre cómo están trabajando Hacia el desarrollo de una «computadora cuántica científica y comercialmente útil» compuesta de 50 qubits – una matriz 7 por 7 de qubits superconductores (cada uno de los cuales está acoplado a su vecino más cercano) que se puede programar con una puerta de uno o dos qubit – que Tiene una tasa de error de alrededor del 0,1% y realmente hace cálculos cuánticos.

Aquí es donde el concepto de «supremacía cuántica» – será capaz de demostrar de manera concluyente la capacidad de realizar un cálculo que una computadora clásica no puede – entra en juego. Para comprobar la validez de tal cálculo, se requerirían los mejores supercomputadores de hoy, y de acuerdo con Martinis, lo más que podrían competir con una computadora cuántica de 50 qubit – más qubits y un supercomputador no serán suficientes. A pesar de eso, Martinis me dice que al entrar en «la era de un montón de qubit», utilizando la supremacía cuántica como una herramienta de evaluación comparativa para ver qué tan bien funciona su sistema es crucial. Para su actual simulador de 9 qubit, «la supremacía nos dio datos muy valiosos y tenemos algoritmos extremadamente precisos para ello», dice.

Aparte de eso, el equipo de Google también está trabajando duro para predecir y corregir los posibles problemas de hardware que puedan surgir a medida que aumentan el número de qubits, cada uno de los cuales debe ser «muy bueno y coherente». Esto incluye algunos requisitos específicos de ingeniería del sistema . Para diseñar mejores procesadores de computación cuántica, el equipo de Martinis contrató a la compañía canadiense Anyon Systems. Por suerte, el director general de la empresa, Alireza Najafi-Yazdi, también estuvo en la reunión de marzo e incluso dio una conferencia de prensa. Najafi-Yazdi, un ingeniero de formación, cofundó la puesta en marcha en 2014 para desarrollar sistemas de software y simulación que ayudan a diseñar y optimizar la electrónica cuántica y otros dispositivos a nanoescala en los que los efectos cuánticos entran en juego.

Anyon Systems se especializa en el desarrollo de herramientas computacionales y simulaciones «masivamente paralelas», utilizando supercomputadoras para ayudar a diseñar el hardware para futuras computadoras cuánticas. La compañía actualmente está colaborando con el equipo de Martinis para «usar el software de simulación de Anyon Systems para predecir la conversación cruzada entre los diferentes componentes de un procesador cuántico de 6 bits», explica Najafi-Yazdi, agregando que «una comparación entre las mediciones experimentales y los resultados numéricos muestran Excelentes acuerdos que demuestran la promesa de herramientas paralelas masivas en la ingeniería de nuevos procesadores cuánticos «. Añadió que algunas simulaciones ya habían revelado posibles problemas con el chip superconductor que podría ser abordado durante la simulación, en lugar de pasar meses construyendo el dispositivo sólo para encontrarlo No funciona como se esperaba.

Antes de que Martinis y yo nos separáramos después de nuestra charla rápida, mencionó que tanto se discute en estas sesiones que todo su equipo se reúne cada noche para discutir ideas, dice que el equipo está realmente trabajando para llegar a 20 qubits muy pronto. «Todo depende de cómo van nuestras soluciones finales. El objetivo de Google es que nuestro equipo de 50 qubit esté listo para finales de este año. Puede suceder, pero estoy más centrado en perfeccionar el chip de 20 qubit ahora. «En cualquier caso, Martinis confía en que su 50-qubit no está tan lejos y es sólo una cuestión de tiempo antes de que tengan un funcionamiento y relativamente libre de errores de la computadora cuántica en su mira … momentos emocionantes de hecho.

Ampliar en: IOP

CWI y Google anuncian la primera colisión para el estándar de seguridad industrial SHA-1

Investigadores del instituto de investigación holandés CWI y Google anunciaron conjuntamente que han roto en la práctica el estándar de seguridad de Internet SHA-1. Este estándar industrial se utiliza para firmas digitales y verificación de integridad de archivos, que protegen transacciones de tarjetas de crédito, documentos electrónicos, repositorios de software de código abierto GIT y distribución de software. El cryptanalista de CWI Marc Stevens dice: «Muchas aplicaciones todavía utilizan SHA-1, aunque fue oficialmente desaprobado por NIST en 2011 después de debilidades expuestas desde 2005. Nuestro resultado demuestra que su abandono por una gran parte de la industria ha sido demasiado lento y que la migración a normas más seguras debería darse lo antes posible «.

El esfuerzo conjunto dirigido por Marc Stevens (CWI) y Elie Bursztein (Google) comenzó hace más de dos años para realizar la investigación avanzada de criptoanalítica de Stevens en la práctica con la infraestructura de computación de Google. Ahora lograron romper con éxito el estándar de la industria SHA-1 usando un llamado ataque de colisión. SHA-1, es un algoritmo criptográfico diseñado por la NSA y que fue estandarizado por NIST en 1995 para computar de forma segura las huellas dactilares de los mensajes. Estas huellas dactilares se utilizan en el cómputo de firmas digitales, que son fundamentales para la seguridad en internet, como la seguridad HTTPS (TLS, SSL), banca electrónica, firma de documentos y software. Las colisiones – diferentes mensajes con la misma huella digital – pueden conducir a falsificaciones de firmas digitales. Por ejemplo, una firma SHA-1 obtenida para un archivo también puede ser mal utilizada como una firma válida para cualquier otro archivo colisionado.

La colisión SHA-1 anunciada es la culminación de una línea de investigación iniciada en el CWI hace más de siete años para desarrollar un ataque práctico óptimo de colisión contra SHA-1. Esto dio lugar previamente al ataque teórico actualmente mejor conocido de Stevens en 2012 en el cual el resultado anunciado se ha construido más adelante. Elie Bursztein dice: «Encontrar la colisión en la práctica llevó un gran esfuerzo tanto en la construcción del ataque criptoanalítico y en su ejecución a gran escala.Requería más de 9.223.372.036.854.775.808 cálculos SHA1 que lgastaría 6500 años de cálculo de la CPU y 100 años de computación GPU. Es más de 100000 veces más rápido que un ataque de fuerza bruta.Usamos la misma infraestructura que potencian muchos proyectos de Google AI, incluyendo Alpha Go y Google Photo, así como Google Cloud «.

Stevens dice: «Las lecciones deberían haberse aprendido de las advertencias sobre ataques similares contra el predecesor MD5 de SHA-1, como la creación de una Autoridad de Certificación deshonesta en 2009 por un equipo internacional del que formé parte y un ataque de los estados nacionales en 2012 para elaborar actualizaciones maliciosas de Windows para infectar las máquinas de destino en el Oriente Medio para el espionaje, que demostré ser una variante de ataque criptográfico desconocido». En el otoño de 2015, Stevens, junto con dos coautores, advirtió que encontrar una colisión SHA-1 podría costar alrededor de $ 75K- $ 120K mediante la explotación de recursos de bajo costo GPU en Amazon EC2, que era significativamente más barato de lo esperado anteriormente.

Para ayudar a prevenir el uso indebido de dichos documentos PDF falsos, el equipo ofrece una herramienta gratuita en línea para buscar colisiones SHA-1 en documentos, que se basa en la técnica de contra-criptoanálisis de Stevens 2013 para detectar si se ha creado un solo archivo con un Ataque de colisión cryptanalítica. Se puede encontrar en: shatterered.io . La misma protección para los documentos PDF es ahora automática para los usuarios de Gmail y Google Drive. Para defenderse contra ataques de colisión SHA-1 los sistemas deben migrar a SHA-2 o SHA-3. En el caso de HTTPS, el esfuerzo para pasar de certificados SHA-1 a certificados SHA-2 comenzó en 2015. Y a partir de este año los navegadores marcarán los certificados basados ??en SHA-1 como inseguros. De forma similar, los sistemas de respaldo y los sistemas de firmas de documentos deben pasar a SHA-2.

Este resultado es fruto de una colaboración a largo plazo entre el Grupo de Criptología de Centrum Wiskunde & Informatica, el instituto nacional de investigación para las matemáticas y la informática en los Países Bajos, y el Grupo de Seguridad de Investigación, Privacidad y Anti-abuso de Google. Hace dos años Marc Stevens y Elie Bursztein, líder del equipo de investigación anti-abuso de Google, comenzaron a colaborar en hacer criptoanalíticas de Marc ataques contra SHA-1 práctica usando la infraestructura de Google. Desde entonces, muchos investigadores de CWI y Googlers han ayudado a hacer posible este proyecto, incluyendo a Pierre Karpman (CWI) que trabajó en el cryptanalísis y la implementación de prototipos de GPU, y de Google Ange Albertini que desarrolló el ataque PDF, Yarik Markov que se encargó de la GPU distribuida Código y Clement Blaisse que supervisaron la confiabilidad de los cálculos.

Más detalles sobre el ataque SHA1, cómo detectarla y el trabajo de investigación que detalla el ataque está disponible en https://shattered.io .

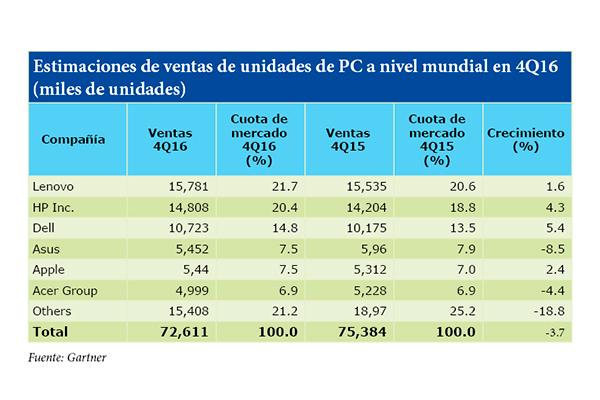

2016 fue el quinto año consecutivo de descenso de ventas de PC

Los últimos datos aportados por Gartner, la consultora y empresa de investigación en el ámbito de las tecnologías de la información, señalan que las ventas mundiales de ordenadores totalizaron los72,6 millones de unidades en el útltimo trimestre de 2016. Una cifra que supone una disminución de 3,7% desde el cuarto trimestre de 2015. De hecho, según la consultora, a partir del año 2015, las ventas de PC han disminuido anualmente. «El estancamiento en el mercado de los ordenadores continuó en el cuarto trimestre de 2016, ya que las ventas durante el periodo de vacaciones de navidad han sido generalmente muy débiles, debido, sobre todo, al cambio fundamental en el comportamiento de compra de ordenadores», apuntó Mikako Kitagawa,analista principal de Gartner. Toda una serie de condicionando que ha provocado que este último año haya sido bautizado como el quinto año consecutivo en el que los ordenadores han perdido en número de ventas. Una tendencia que según los analistas de Gartner comenzó en el año 2012. Y aunque Kitagawa señaló que, por lo general, el mercado de PCs sufrirá un estancamiento, también existen oportunidades de crecimiento dentro del mercado, tales como el mercado de usuarios de PC, el mercado empresarial y los juegos. Sin embargo, estas áreas de crecimiento no evitarán la caída general del mercado de ordenadores, al menos en el próximo año. Con todo ello, cuatro de los seis principales proveedores experimentaron un aumento en los envíos de PC a nivel mundial en el cuarto trimestre de 2016, mientras que los tres principales proveedores aumentaron su cuota de mercado global en el cuarto trimestre.

Ampliar en: Electromarket

El nuevo ordenador de Intel tiene el tamaño de una tarjeta bancaria

Los dispositivos conectados a internet están por todas partes, no importa el tipo de producto ni la finalidad de su conexión, internet de las cosas (IoT) es el futuro y en el CES 2017 se han presentado multitud de productos inteligentes conectados.

Por ejemplo, se dispone de un televisor de un última generación, de lo más potente y avanzado en el mercado. Dentro de tres años probablemente no lo sea y, su hardware ya no será lo suficientemente potente como para soportar el nuevos software y las nuevas funciones.

Siguen apareciendo monedas dentro de algunos Apple MacBook

Un usuario de Imgur compartió algunas fotos que pueden explicar la diferencia más importante entre la unidad óptica de algunos equipos Apple y la que incluiría cualquier otra marca. La unidad en su MacBook Pro tenía pegado un centavo de dólar estadounidense debajo del plástico.

Greatease no ha sido la única persona en encontrar monedas en sus unidades ópticas. En 2010 la web Gizmodo publicó el vídeo de un usuario que encontró un cuarto de dólar en la unidad óptica SuperDrive de su Apple MacBook. El vídeo de 40 segundos fue subido a YouTube por Greg Kilpatrick. En 2013 el usuario Unplottable publicó en Mac Rumors la foto de un cuarto de dólar canadiense en una unidad SuperDrive, quien aseguró que compró su MacBook en el año 2011 directamente en una Apple Store en Montreal.

Otro teléfono Samsung explota y calcina un coche por completo

Los dueños del vehículo se encontraban en un pequeño mercado local. Y mientras preparaban un escritorio que habían comprado para su hija, el hombre había dejado su nuevo Samsung Note 7 cargando dentro del coche Jeep. Cuando iban a volver su perro los estaba alertando, pero ya era demasiado tarde: el auto estaba en llamas.

Según informaron en las noticias de la FOX 13 , un representante de Samsung estaría al tanto de la situación y haría “todo lo posible” por la familia.

Fuente: conéctica

IBM logra fabricar las primeras neuronas artificiales con tecnología de cambio de fase

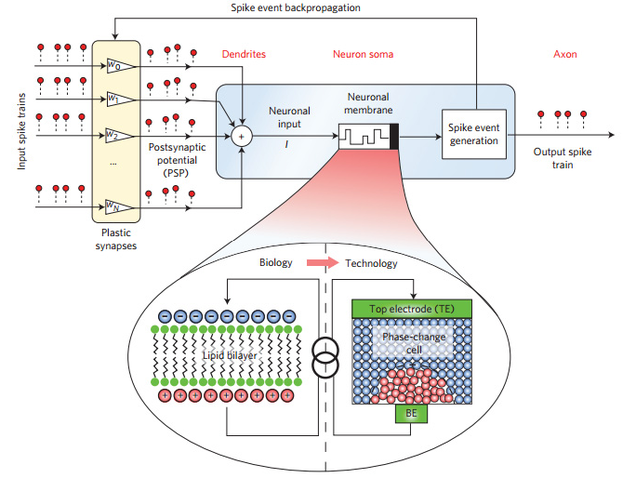

Durante décadas, la ciencia ha tratado de recrear la estructura del cerebro humano, pero hasta ahora era imposible imitar su potencia y densidad con los componentes disponibles. IBM acaba de dar un paso interesante hacia el cerebro positrónico imaginado por Asimov. Ha creado neuronas artificiales funcionales mediante tecnología de cambio de fase.

No es la primera vez que IBM anuncia un avance en esta tecnología de almacenamiento no volátil (los datos no desaparecen al apagar el dispositivo) basada en cristales que alteran su estructura molecular al recibir corriente eléctrica de diferente intensidad. Recientemente la compañía logró crear memoria de cambio de fase a un coste similar al de la RAM actual.

Esquema de las neuronas artificiales de cambio de fase. Foto: IBM

Sin embargo, este nuevo avance de IBM va mucho más allá de lograr que nuestro PC funcione con más agilidad. Lo que el equipo de investigadores que la compañía mantiene en Zurich ha logrado crear son neuronas que imitan perfectamente el funcionamiento de las neuronas humanas. En lugar de una membrana con enzimas, las neuronas artificiales unen el axon y las dendritas mediante un cristal de antimonio, germanio y telurio, un material similar al que se utiliza en los discos ópticos reescribibles.

Estas neuronas de cristal que cambia su estado se parecen mucho a su contrapartida biológica. Para empezar, su tamaño puede reducirse a unos pocos nanómetros, lo que permite agrupar la suficiente cantidad de estas neuronas en un espacio lo bastante reducido.

En la primera prueba, IBM ha puesto a funcionar 500 de estas neuronas en una hilera de cinco chips compuestos de 10×10 de estas neuronas, pero el sistema es escalable. Los investigadores explican en el estudio que han publicdo en Nature que se podrían crear chips viables para comercialización de 90 nanómetros ya mismo, y que en el futuro se podría reducir hasta 14 nanómetros.

… …

Artículo completo en: GIZMODO

autobus las palmas aeropuerto cetona de frambuesa